Der Stand der Kernspaltungs- und Kernfusionsforschung weltweit

Dr. Azima ist aktiver Physiker in Hamburg, diplomiert in Inertial-Fusionsforschung und Laserphysik an der Gesellschaft für Schwerionen Forschung (GSI) Darmstadt.

Im Februar 2019 betrug der Durchschnittsstrompreis für einen deutschen Privathaushalt ca. 30,5 Cent/kWh.1 Dies ist der höchste Strompreis in Europa und der höchste jemals in Deutschland ermittelte Preis für elektrische Energie. Um zu verstehen, woher dieser hohe Preis kommt, muß man die Energiewendepolitik der vergangenen 15 Jahre in Deutschland betrachten. Obwohl der Ausstieg aus der Kernenergie bereits zuvor beschlossene Sache war, hat die Kraftwerkskatastrophe in Fukushima den politischen Hauptausschlag für einen schnellen Wechsel in Deutschland erbracht. Die Regierung hat den frühen Aufschrei der öffentlichen Meinung unmittelbar aufgegriffen und den Ausstieg aus der Kernenergie auf das Jahr 2022 vorgezogen.

Der zweite massive politische Druck, der zur Energiewende führte, ist der gemäß der Regierung sowie der meisten Umweltverbände menschengemachte Klimawandel durch CO2-Ausstoß, so daß sämtliche Energieträger, die auf Verbrennung basieren, langfristig zur Disposition gestellt werden sollen.

Übrig bleiben dieser Logik nach dann zwangsläufig die regenerativen Energieträger aus im wesentlichen Sonne und Wind, aus denen wir heute zu bereits 40% alle elektrische Energie erzeugen, wovon jedoch der größte Teil wieder ins Ausland verklappt werden muß, da er nicht in Deutschland auf eine zum jeweiligen Zeitpunkt genügend hohe Nachfrage trifft.2 Doch die Frage bleibt, wieso die Umstellung auf regenerative Energie zu dem höchsten Preis in Europa geführt hat, wo doch Sonne und Wind kostenlos in großer Fülle zur Verfügung stehen und der Preis somit automatisch viel geringer als der für sonstige nicht-regenerative, d.h. „verbrauchende“ Energieformen sein sollte – insbesondere angesichts der immensen Investitionen, die in die deutsche Energiewende geflossen sind und fließen: seit dem Jahr 2000 bis zum Jahr 2025 werden hierfür insgesamt 520 Mrd. € von deutschen Bürgern in der Art einer für alle anfallenden Kopfsteuer (EEG-Umlage auf Strompreis) aufgebracht und investiert sein werden.3

Diesen Widerspruch sauber aufzulösen, ist eine komplexe Angelegenheit, in die sehr viele verschiedene Parameter einfließen, da hierbei grundverschiedene Technologien verglichen werden müssen. Ich beschränke mich daher nur auf einen Hauptaspekt der Energiewende, welcher aber meiner Ansicht nach den maßgeblichen Kostenfaktor für unseren heutigen Strompreis darstellt.

Energieflußdichte

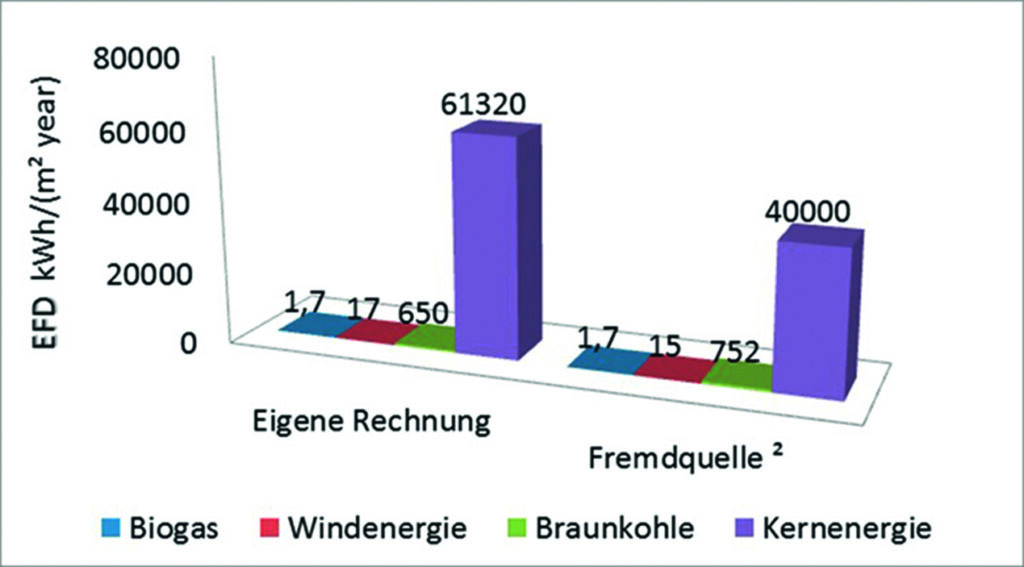

Das dritte der vier Grundgesetze des Ökonomen Lyndon LaRouche bezieht sich auf die allgemeine Energieflußdichte (EFD) innerhalb eines Landes und dem Gebot, diese stetig zu maximieren. In Abbildung 1 wird die EFD unterschiedlicher Energieträger in Relation zueinander gestellt. Es ist unschwer zu erkennen, daß beide Datenquellen zum gleichen Schluß kommen, nämlich daß die Kernenergie eine um fast zwei Größenordnungen höhere Energieflußdichte besitzt als alle anderen. Die Tagesschau hat die Problematik in einem Satz auf den Punkt gebracht: „Der Windpark, der ein Kernkraftwerk ersetzen könnte, hätte etwa die Fläche des Landes Bremen“.45

Dies bedeutet, daß die regenerativen Kraftwerke breit gestreut und über das Land verteilt errichtet werden. Den Ort bestimmt dabei nicht die Nachfrage nach Strom, sondern das Angebot an regenerativer Energie. Dieser Strom muß jedoch zum Verbraucher geführt werden, was bei der Vielzahl von notwendigen Kleinkraftwerken unweigerlich zu einem äußerst komplexen und damit teuren und fehleranfälligen Leitungsnetzwerk führt. Einfach gesagt, was an der Erzeugung durch die kostenlos verfügbaren natürlichen Energiequellen gespart wurde, steckt nun in den Transportkosten des Stroms.

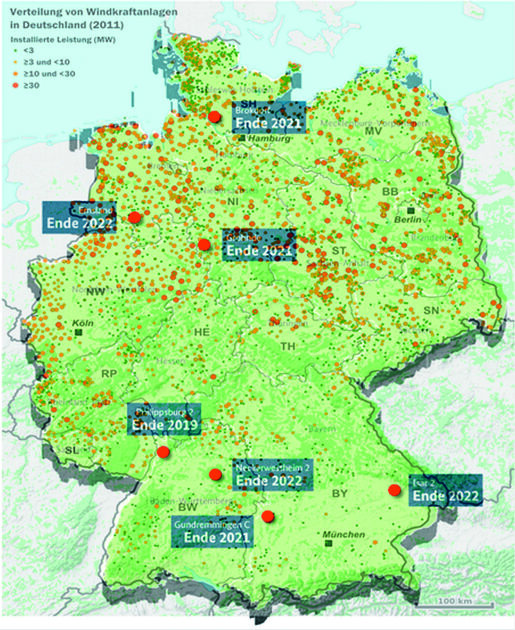

Plastisch erkennbar wird dieser Zusammenhang in Abbildung 2.

In dieser sind als beige Punkte alle bis zum Jahr 2016 errichteten Windräder eingezeichnet und als rote Punkte alle Atomkraftwerke, die zu diesem Zeitpunkt in Summe genauso viel Energie erzeugten wie alle Windkraftanlagen zusammengenommen. Anhand dieser Darstellung läßt sich die fundamentale Philosophie der Energiewende verstehen. Dem alten Konzept des „Zentralkraftwerks“ (ZKW) wurde ein „dezentrales“ Netz von Kleinkraftwerken gegenübergestellt. Die wesentliche argumentative Begründung der Befürworter ist, daß so das Monopol der Stromerzeugung gebrochen werden könne. Dies ist jedoch ein rechtlich-politisches Problem und kein technisches. Auf technischer Ebene machen Zentralkraftwerke ökonomisch viel mehr Sinn, da diese genau dort platziert werden können, wo sich auch der Verbraucher befindet, und nicht dort, wo der Wind weht, und somit die Transportkosten von ZKWs grundsätzlich viel geringer sind.

Die Einfachheit eines solchen Stromnetzes aus ZKWs reduziert darüber hinaus die Fehleranfälligkeit des Netzwerks, da ZKWs zugleich Grundlastkraftwerke sind, die einer volatilen Stromnachfrage ein stabiles Angebot entgegenstellen. Dieses können Windkraftanlagen nicht leisten, da sich der Wind nicht nach dem Verbraucher richtet und somit ein gigantischer Energiespeicher zur Glättung der Schwankungen benötigt wird, den es bisher weder gibt, noch für den realistische, technisch machbare Lösungen wenigstens als Idee in Sicht wären.

Das letzte relevante Argument gegen die Dezentralisierung ist das der Skalierbarkeit. Wie man unschwer an der Karte erkennen kann, ist der Platz für zusätzliche Windkraftwerke beschränkt. Sollte sich in einer ferneren Zukunft durch das Wirtschaftswachstum der Stromverbrauch zum Beispiel verdoppeln (Stichwort „Elektrifizierung des Verkehrs“), wird es problematisch werden, genug weitere regenerative Kleinkraftwerke zu einem akzeptablen Preis zu errichten. Das heißt, der Ansatz der „Zentralisierung“ ist ein „lineares Modell“.

Dieses Problem können Zentralkraftwerke wesentlich einfacher lösen, da sie aufgrund ihres geringen Platzverbrauchs sehr leicht verdoppelt oder verdreifacht werden können, andererseits aber die Ausbeute pro Fläche durch technischen Fortschritt zusätzlich wachsen kann.

Als Beispiel: Ein Gaskraftwerk von 200 MW Leistung kann durch ein Kernkraftwerk der siebenfachen Leistung bei etwa gleichem Platzbedarf ersetzt werden. Windkraftanlagen haben jedoch eine eindeutige physikalische Grenze hinsichtlich ihrer maximalen Ausbeute, die man auch nicht mehr durch technischen Fortschritt erweitern kann, ohne die Gesetze der Physik zu verletzen. Diese Grenze ist aber nur doppelt so hoch wie die Energieeffizienz heutiger Windkraftanlagen und nicht siebenmal so hoch wie in dem genannten Beispiel!

Fassen wir zusammen: Der (auch inflationsbereinigte) hohe Preis heute verglichen mit dem vor 15 Jahren setzt sich zusammen aus einem erhöhten Platzbedarf der regenerativen Kraftwerke, einem deutlich aufwendigeren Leitungsnetzwerk als zuvor und durch den Einsatz einer deutlich schwächeren Energiequelle als zuvor, die nicht beliebig skaliert werden kann. Diese drei Punkte können zusammen genommen nicht durch die vermeintliche Kostenlosigkeit der natürlichen Energiequellen kompensiert werden. Kritik an der deutschen Energiewende wurde mittlerweile auch von nationaler Seite (Bundesrechnungshof, Sept. 2018)6 und internationaler Seite (World Economic Forum)7 geübt.

Es sei hier jedoch erwähnt, daß die Bundesregierung davon ausgeht, daß wir uns momentan noch in einer Übergangsphase zu einer vollständig regenerativen Stromerzeugung befinden und daß sich der Preis durch Synergieeffekte bei einem weiteren Ausbau auf geplante 80% wieder verringern wird. Dies ist eine Prognose.

Die persönliche Meinung des Autors ist hierzu eindeutig. Es wäre besser gewesen, die besagten 520 Mrd. €, welche die Energiewende bisher gekostet hat und noch kosten wird, in die Weiter- und Neuentwicklung der Kernenergie zu investieren, um deren fundamentale technischen Schwächen final zu beseitigen und so das ultimative Zentralkraftwerk zu bauen. Ein solches wäre vielleicht sogar ein Kernfusionskraftwerk. Dazu mehr weiter unten.

Die Schnelle-Brüter-Technologie

Wie den Älteren wohl bekannt ist, wurde das Projekt eines deutschen Schnellen Brüters in Kalkar durch eine SPD-geführte Regierung unter Ministerpräsident Rau in NRW nach Fertigstellung und noch vor Inbetriebnahme vorzeitig im Jahr 1985 beendet. Dies ist nun ca. 30 Jahre her. Seither ist diese Technologie jedoch weltweit nicht aufgegeben worden, sondern wurde konsequent von zahlreichen Ländern weiterentwickelt, u.a. in Rußland, Frankreich, China, Japan, Südkorea und Indien. Es gibt Blei-Bismut- oder Natrium-gekühlte Versionen. Ihnen allen gemein ist, daß sie im Gegensatz zu konventionellen Leichtwasser-Reaktoren, die mit thermischen Neutronen arbeiten, nicht auf ungradzahlige Isotope des Urans, insbesondere U-235, angewiesen sind, sondern im Prinzip auch U-238 oder Pu-238 verbrennen können. Die Ursache dafür ist, daß der Absorptionsquerschnitt von schnellen Neutronen über alle Isotope relativ gleich hoch ist, während dieser für langsame Neutronen bei geraden Isotopen ungefähr bei null liegt, was quantenmechanische Ursachen hat. Der Grund, weshalb man nicht gleich die schnellen Reaktoren baute, war, daß mit den Leichtwasser-Reaktoren atomwaffenfähiges Plutonium als Abfallstoff leichter produziert werden konnte und sich die Kühlung technisch einfacher gestaltete.

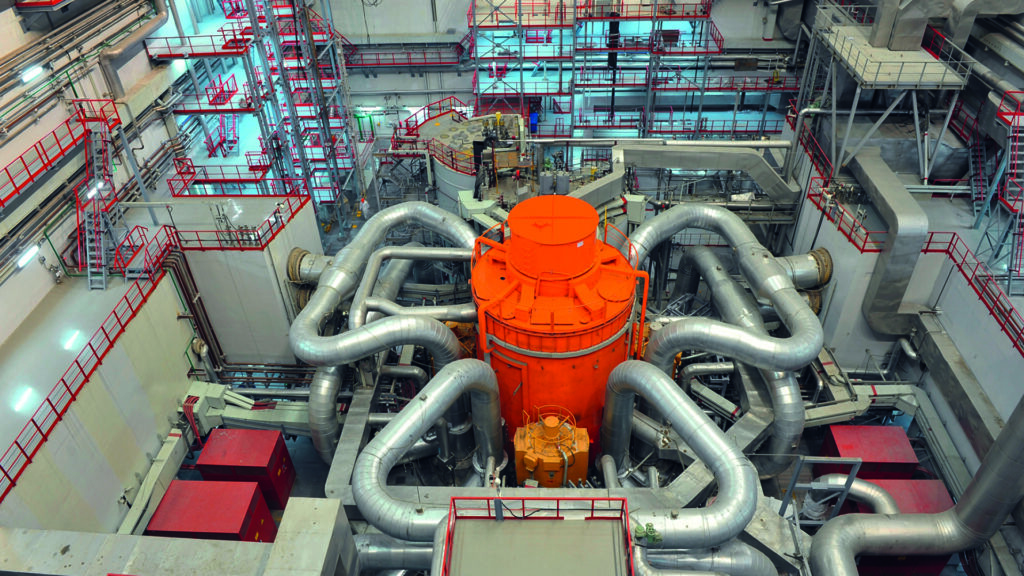

Auf die Vor- und Nachteile der zahlreichen Untertypen von Reaktoren der 4. Generation kann hier nicht genauer eingegangen werden. Tatsache ist nur, daß die Forschung an dieser Technik heute weltweit intensiv betrieben wird (nur nicht in Deutschland) und bereits einer dieser schnellen Reaktortypen der 4. Generation heute Strom produziert – der russische BN-800 in Belojarsk (Abbildung 3). Der Hauptzweck dieses Demonstrationsreaktors, der seit 2019 vollständig mit MOX-Brennstoff betrieben wird, war es, waffenfähiges Plutonium in Rußland in Absprache mit den USA zu reduzieren. Durch den 100%en Einsatz von MOX als Brennstoff seit Anfang 2019 erfüllt dieser Reaktor darüber hinaus seine Rolle als technischer Meilenstein hin zu einem vollständig geschlossenen Brennstoffkreislauf, in dem sowohl wahlweise frisch erbrütetes Plutonium zusammen mit etwas angereichertem Uran als auch Atommüll aus Leichtwasserreaktoren als Brennstoff zum Einsatz kommen kann, momentan aber nur MOX aus Leichtwasser-Reaktoren genutzt wird. Der BN-800 verbrennt in einem Brennstoffzyklus, der ca. 730 Tage dauert, automatisch auch langlebige Actiniden und wandelt diese in kurzlebige radioaktive Reststoffe um, welche dann in einem Zwischenlager 100 bis 300 Jahre gelagert werden. Der Aufwand und die Kosten hierfür sind dabei deutlich geringer als für ein (nach Meinung des Autors technisch utopisches und damit nicht realisierbares) Endlager aufgrund der deutlich geringeren Sicherheitsanforderungen. Ferner reduziert sich durch den Recycling-Vorgang der gesamte Atommüll pro erzeugte Energiemenge im Vergleich zu einem herkömmlichen AKW deutlich.8 Bis zum Jahr 2016 war der Kern des BN-600 (der Vorläufer des BN-800) als schneller Brenner konfiguriert, so daß mehr Plutonium verbrannt als neu erbrütet wird, gerade um das waffenfähige Pu zu vernichten.

Hinsichtlich der Sicherheit des BN-800 ist anzumerken, daß in der Tat die Gefahr eines Natrium-Brandes besteht, da in einem Sekundärkühlkreislauf auch Wasser eingesetzt wird. Ein Natrium-Leck würde aber nicht sofort zu einer unkontrollierten Wasserstoff-Explosion führen, sondern könnte relativ leicht wieder verschlossen werden, da das austretende Natrium mit Luft zu Natrium-Oxid verbrennt, ein Feststoff mit höherem Schmelzpunkt als Natrium, und sich dadurch das Leck quasi von selbst abdichten würde, noch bevor es mit Wasser in Berührung käme. Zweitens wird der Reaktorkern nur bei Normaldruck betrieben. Und drittens hat auch dieser Reaktor (sowie alle Schnellen Neutronen-Reaktoren) einen negativen thermischen Koeffizienten, so daß bei höherer Temperatur die Kernspaltungsrate kleiner wird und sich der Reaktor somit inhärent selbst kühlt und regelt. Der Betreiber gibt an, daß pro Jahr und in einem Radius von 3 km um den Reaktor eine Strahlenbelastung von 23 mSv nicht überschritten wird.

Bis zum vollständigen Ausstieg aus der Kernenergie wird in Deutschland noch eine Gesamtmenge von ca. 10.000 t hoch radioaktivem Müll anfallen, der endgelagert werden müßte.9 Sollte man diesen Müll nicht besser ganz und gar verbrennen, als ihn unseren Nachkommen in einem technisch niemals ausgereiften Endlager zu überlassen? Insbesondere wenn mit der geeigneten Technologie daraus noch Energie gewonnen werden kann? Und selbst wenn Deutschland ganz ausgestiegen sein sollte, so kann es doch nur anderen Ländern als Vorbild dienen, das entweder angenommen wird oder nicht.

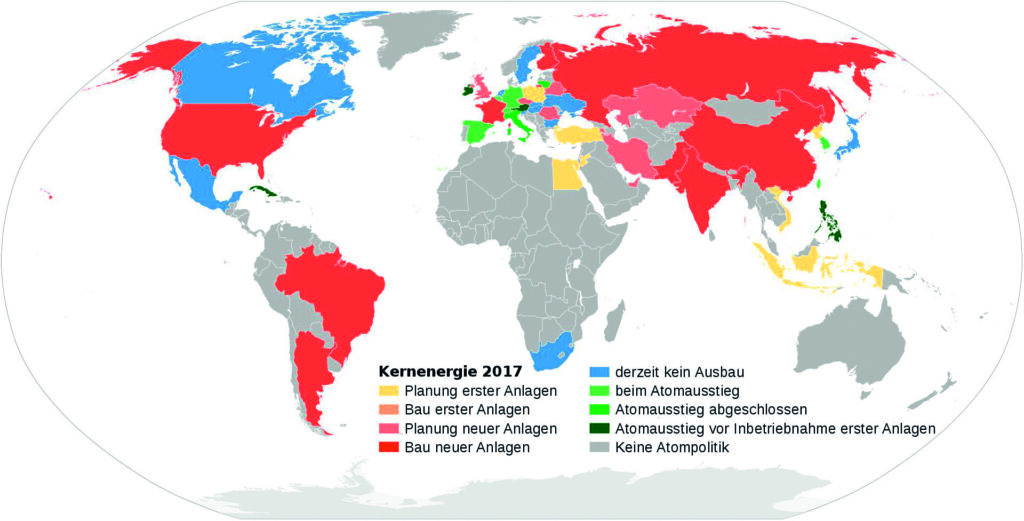

Nach der derzeitigen Sachlage scheint ein großer Teil der Welt allerdings einen entgegengesetzten Weg einzuschlagen, wie aus Abbildung 4 hervorgeht, worin der Stand der Kernenergieentwicklung weltweit dargestellt ist – rot: neue KKWs, grün: Ausstieg.

Und wenn bei uns der Wind nicht weht oder die Sonne nicht scheint, werden wir „insbesondere aus unseren Nachbarländern (Frankreich und Polen) noch über eine lange Zeit Atomstrom aus veralteten und deutlich unsichereren Kraftwerken (als die deutschen Meiler) beziehen,“ so der Vorsitzende der Jungen Union, Tilmann Kuban, am 22.03.2019.

Der Wettlauf in der Kernfusionsforschung

Weitgehend unbemerkt von der öffentlichen Wahrnehmung in Deutschland sind in den vergangenen 20 Jahren weltweit eine Vielzahl konkurrierender Ansätze zur Beherrschung der zivilen Kernfusionsnutzung entstanden. Dabei wurden sowohl neue, unkonventionelle und alternative Methoden ausprobiert, aber gleichzeitig auch die altbekannten Technologien vorangetrieben.

Um eine Übersicht zu erhalten, betrachten wir zunächst zwei wesentliche Ansätze, die Inertial- oder auch Trägheitsfusion sowie die elektromagnetische Einschlußfusion. Bei der Inertialfusion wird ein Fusionsbrennstoffpellet (D-T) durch zahlreiche kugelsymmetrisch angeordnete gepulste hochenergetische Laserstrahlen schlagartig erhitzt und so eine Schockwelle erzeugt, welche das Pellet von allen Seiten stark komprimiert, wobei die Dichte dabei 1000mal höher wird als die des kalten Pellets. Um diesen Prozeß noch effektiver zu machen, wird mit einem zweiten Laserpuls in das komprimierte Plasma mittels Röntgenlichtkonversion geschossen (Driver), wodurch das komprimierte Pellet zusätzlich erhitzt wird. Mit dieser Methode konnte vor einigen Jahren ein erster Durchbruch erzielt werden, wobei ein sog. Mini-Breakeven erreicht wurde.10

Die zweite wohlbekannte Methode, die magnetische Einschlußfusion, repräsentiert durch Tokamak und Stellarator, wird nach wie vor in experimentellen Reaktoren weltweit untersucht und optimiert, mit dem Ziel, durch den ITER-Reaktor einen ersten Demonstrationsreaktor mit positiver Energieausbeute zu realisieren. Einen momentanen Weltrekord hierbei hält jedoch der chinesische supraleitende EAST-Tokamak, mit einer Rekordeinschlußzeit von 100 Sekunden.11

Daneben gibt es aber noch eine Vielzahl privatwirtschaftlich finanzierte Methoden, die hier kurz erwähnt werden sollen.

- Die Firma Tri-Alpha, mit 500 Mio $ unterstützt durch den amerikanischen Philanthropen Paul Allen, will zwei Plasmaringe mit hoher Geschwindigkeit aufeinander feuern und durch die dabei entstehende elektromagnetische Wechselwirkung eine genügend hohe Plasmadichte und Temperatur ausreichend lange für Fusionsreaktionen erzeugen.12

- Die Firma Lockheed Martin hat mit dem Compact Fusion Reactor (CFR) eine Abwandlung der „mirror machine“ entwickelt.13

- Die Firma EMC2 verfolgt das Fusor-Konzept, bei dem durch magnetisch eingeschlossene freie Elektronen zunächst eine virtuelle Kathode aufgebaut wird, durch welche die von außen kugelsymmetrisch eingebrachten positiv geladenen Brennstoffionen zentro-symmetrisch nach innen beschleunigt und dabei genau im Zentrum fokussiert und dabei durch möglichst frontale Stöße verschmolzen werden.14

- Die Firma General Fusion will die oben beschriebene Schockwelle zur Kompression des Plasmapellets nicht mittels Laserpulsen, sondern mittels sehr starken pneumatischen Kolben erzeugen.15

- Die Firma LPP-Fusion hat das Prinzip des dynamischen Theta-Pinch-Verfahrens aufgrund neuer Erkenntnisse und mit verbesserten Methoden neu aufgegriffen und konnte damit sehr bemerkenswerte Erfolge erzielen.16

Alle diese Verfahren haben ihre Vor- und Nachteile, ohne an dieser Stelle im Detail auf jede einzelne eingehen zu können.

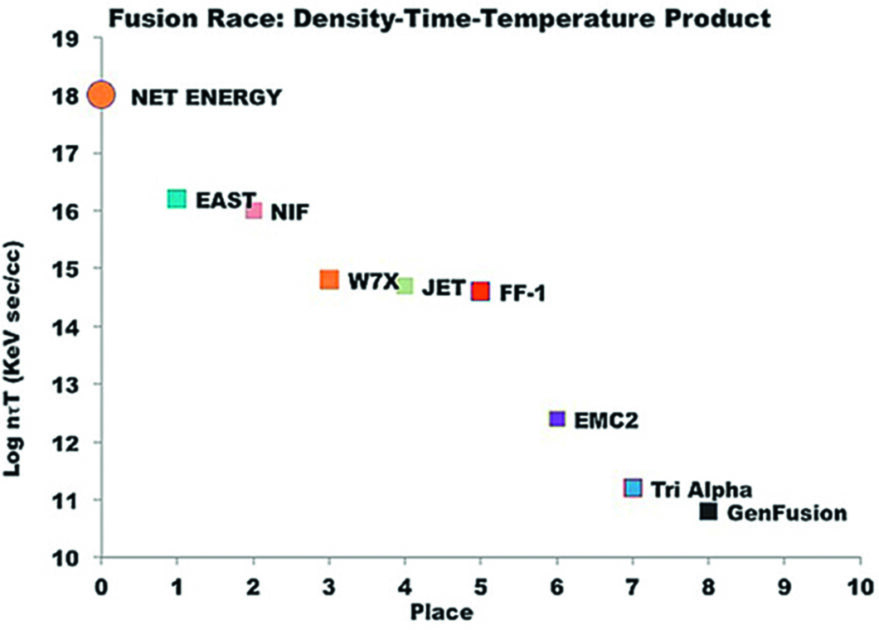

Die folgende Übersicht (Abbildung 5) zeigt eine Möglichkeit, diese Verfahren miteinander zu vergleichen. Dabei wird das Produkt aus Einschlußzeit und Fusions-Targetteilchendichte verwendet. Erst bei genügend hohem „nT-tau“-Faktor kann ein Reaktor Netto-Energie produzieren, was für alle Fusionsansätze gleichermaßen gilt. In dieser Darstellung fällt auf, daß die Firma LPP-Fusion (FF-1) von allen privatwirtschaftlich finanzierten Projekten den höchsten „nT-tau“-Faktor erzielen konnte, sich jedoch noch hinter den staatlich finanzierten Großforschungsprojekten befindet.

Komplettiert werden sollte diese Übersicht noch mit dem jeweiligen Investitionsvolumen, das aufgewendet wurde, um die einzelnen Forschungsprojekte zu realisieren. Während Tri-Alpha mit 0,5 Mrd. $ nur einen „log(nT-tau)“-Faktor von 11 erzielt hat, konnte LPP-Fusion mit nur ca. 0,006 Mrd. $ eingesetztem Kapital einen Faktor >14 (also 1000x mehr) erzielen.

Aus diesem Grunde sollte diesem Konzept mehr Aufmerksamkeit geschenkt werden. Der dynamische Theta-Pinch wurde bereits in den 1980er Jahren in Deutschland erforscht (Projekt „POSEIDON“ in Stuttgart).17 Der Trick dieser Methode ist es, zahlreiche hochenergetische Lichtbögen in einer kreissymmetrischen Weise zu bündeln, wodurch mittels Selbstinduktion ein Plasmaeinschluß und eine Kompression erzielt wird. Dabei wird eine sog. magneto-hydrodynamische Instabilität ausgenutzt, wie sie auch im Plasma von Tokamaks entsteht, dort aber möglichst unterdrückt wird. Die dabei von LPP-Fusion erreichten Plasmakennzahlen sind beeindruckend. Es konnte in einem Deuterium-Testplasma eine Temperatur von 3 Mrd. °C erreicht werden, wobei 1011 Fusionsreaktionen pro Zündung erzielt wurden.18

Das Ziel des Reaktorkonzepts von LPP-Fusion ist sehr attraktiv. Es handelt sich hierbei um einen Mini-Fusionsreaktor, der in ca. 1 m³ Volumen19 bis zu 5000 kW Strom erzeugen soll, wobei die Temperatur ausreicht, um die p-B11 Reaktion zu nutzen.

Bei dieser Reaktion werden keine Neutronen frei, sondern ein gerichteter Alpha-Partikel-Strahl, welcher mit mindestens 80% Effizienz direkt durch elektromagnetische Induktion (ähnlich einem Transformator) in Spulen in Strom umgewandelt werden kann. Das heißt, es entsteht keinerlei radioaktive Strahlung, es müßten keine zerstörten Neutronen-Blankets im Tokamak regelmäßig erneuert werden, und es müßten keine Energieverluste durch dampfgestützte Kraft-Wärmekopplung ausgeglichen werden. Ein solcher Reaktor ließe sich bequem in einer Lokomotive, einem Schiff oder sogar in einem Langstreckenpassagierflugzeug einsetzen, deren Elektromotoren über viele Wochen mit minimalem Brennstoffeinsatz angetrieben werden. Die Lokomotive, das Schiff oder Flugzeug wären somit energetisch autark. Natürlich sind noch viele andere Anwendungen denkbar. Der Reaktor ist zu 100% sicher und zu 100% sauber.

Dieses Konzept hat den Autor so überzeugt, daß er selber in Kooperation mit dem Eigner der Münchner Firma „Paul Hoess KG / Stanford Computer Optics, Inc.“, Herrn Paul Hoess, an diesem Reaktor mit sehr begrenzten Mitteln zur Unterstützung der Arbeiten von LPP-Fusion forscht. Wobei wir natürlich hoffen, auch auf diesem Wege – ähnlich wie in den Vereinigten Staaten – einen Philanthropen zu finden, der diese Arbeit unterstützt.

Wo steht Deutschland?

Betrachten wir noch kurz die zur Fusionsforschung in Deutschland eingesetzten Mittel. So hat das Bundesforschungsministerium in den Jahren 2011 und 2012 0,137 bzw. 0,133 Mrd. € für sämtliche Fusionsforschungsanlagen in Deutschland aufgewendet.20 Man möge diese Zahlen wieder in Relation zu den Ausgaben für die Energiewende betrachten, bei der bis ins Jahr 2025 über 520 Mrd. € investiert sein werden (siehe Fußnote 2). Wer kann schon sagen, wo wir heute wären, wenn nur ein kleiner Teil dieser Summe stattdessen für die Fusionsforschung eingesetzt worden wäre?

Ich hoffe, ich konnte Ihnen eine nützliche Übersicht geben und den deutschen Weg zur Lösung der Energieprobleme objektiv dem anderer Länder gegenüberstellen. Bitte bewerten Sie das hier Dargestellte eigenständig, nüchtern, kritisch und möglichst rational. Nichts ist zweckloser, als technologische Probleme durch ideologisches Denken lösen zu wollen, da die Naturgesetze letztlich unüberwindbar und für alle gleich sind.

2. Fraunhofer ISE Stromproduktion 2014, S.165-215, sobald Strom aus Wind und Solar erzeugt wurde, stieg der Export um etwa die gleiche Menge.

3. https://www.welt.de/wirtschaft/article158668152/Energiewende-kostet-die-Buerger-520-000-000-000-Euro-erstmal.html

5. Dr. Günter Keil, http://www.ageu-die-realisten.com/archives/1473.

7. https://www.welt.de/wirtschaft/article174721327/Energiewende-Index-Im-weltweiten-Vergleich-schneidet-Deutschland-schlecht-ab.html.

8. Dieser Vorteil folgt aus der Spaltbarkeit der geradzahligen Isotope mit schnellen Neutronen. Trotz gründlicher Recherche konnte jedoch keine belastbare Zahl hierzu gefunden werden.

9. https://www.atommuellreport.de/themen/atommuell/einzelansicht/radioaktive-abfaelle-mengenuebersicht.html.

10. Nature, volume 506, pages 343–348 (20 February 2014).

17. U. Jäger and H. Herold 1987 Nucl. Fusion 27 407.

18. Lerner E., et al., Phys. Plasmas 24, 102708 (2017).

19. Das Volumen des Reaktorkerns ist dabei vergleichbar mit dem Volumen eines 1-Zylinder-Verbrennungsmotors mit 55 kW.