Wir veröffentlichen diesen (geringfügig gekürzten) Aufsatz aus dem Jahre 2006 erstmals auf Deutsch, um unseren Lesern die Denkmethode in Erinnerung zu rufen, die Lyndon LaRouche in der Wissenschaft der physikalischen Ökonomie entwickelt hat. Auf einzigartige Weise werden hier die Zusammenhänge zwischen Physik, Geometrie, Ökonomie und klassischer Kunst deutlich, angewendet auf den Irrglauben von Norbert Wieners Konzept von „Kybernetik“ und „künstlicher Intelligenz“.

Die Welt treibt derzeit auf eine baldige, allgemeine Zusammenbruchskrise des transatlantischen Währungs- und Finanzsystems zu. Der Zusammenbruch selbst ließe sich durch Methoden abwenden, die eine Rückkehr zu der Anschauung hinter den großen Reformen von US-Präsident Franklin Delano Roosevelt bedeuteten. Um diese notwendige Reform zu verwirklichen, muß ein besonderes Hindernis aus dem Weg geräumt werden, das darin besteht, daß die Generation, die heute in den transatlantischen Machtzentren tonangebend ist – der Jahrgang, der zwischen Ende des Zweiten Weltkriegs und dem Beginn der schweren Rezession 1957-58 geboren wurde –, die Verbindung zu den Erfahrungen der zwei vorhergehenden Generationen mit dem Aufschwung unter Franklin Roosevelt und dem Krieg von 1939-45 verloren hat, welche für den Sieg über das Hitler-Regime entscheidend gewesen sind. Die gleichen Erfahrungen waren auch für den Aufschwung in den zwei folgenden Nachkriegsjahrzehnten unabdingbar.

Im Kern der Desorientierung, die sich unter den Trendsettern der heute vorherrschenden Oberschicht politischer und wirtschaftlicher Macht breitgemacht hat, steht der Irrglaube an heute verbreitete Konzepte wie „Informationstheorie“, „nachindustrielle Gesellschaft“, „Postmodernismus“ und „Globalisierung“. Es ist unbedingt erforderlich, diese derzeit grassierenden Formen der Sophistik beim Namen zu nennen und gegenteilige, geeignete Maßnahmen zu ergreifen, um die Gesellschaft wieder in einen gesunden Geisteszustand zu versetzen.

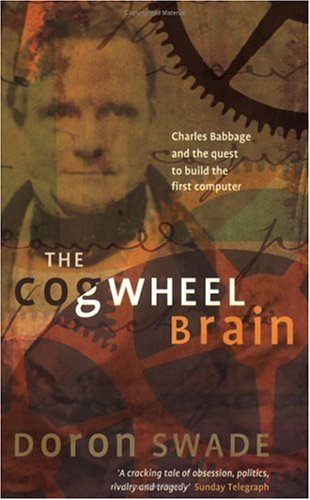

In diesem Zusammenhang hat mich vor etwa sechs Jahren der inzwischen verstorbene, unbeugsame Mark Burdman auf ein Buch von Doron Swade, The Cogwheel Brain (Das Zahnrad-Hirn), aufmerksam gemacht, das ich damals auf Marks Anraten für EIR besprochen habe.1 Wie Swades Titel offen besagt, ist dieses Buch, auch wenn man dem Autor bestimmte Fachkompetenzen nicht absprechen kann, deutlich von einer postmodernistischen Sophistik beeinflußt, was vor allem in Swades Darstellung von Charles Babbage deutlich wird, dessen Konzeptionen der Entwicklung des elektronischen Computers im 21. Jahrhundert zugrundeliegen.2 Die Themen, auf die mich Mark damals ansprach, haben für die heute heranwachsende Erwachsenengeneration eine ganz neue Relevanz.

Die damalige Nachricht von Mark an mich ist noch heute von Bedeutung. Ich führe sie deswegen hier an:

„Ich denke, Du wirst dieses Buch interessant und empörend zugleich finden. Du kannst damit verfahren, wie Du willst.

Ich habe es durchgelesen und fand die ‚Handlung‘ fesselnd, aber der Autor ist entweder uninformiert oder verrückt, was wissenschaftlich-epistemologische Grundfragen angeht, so etwa auf S. 84 seine Gleichsetzung von Leibniz und von Neumann als Mathematiker, die sich mit ‚Symbolen‘ beschäftigen, usw.

Der Autor Swade erwähnt wiederholt Babbages Verbindungen zum europäischen Kontinent, zu [Alexander] von Humboldt und den französischen Kreisen, die auf Lazare Carnot zurückgehen, usw. Das wird aber nie im einzelnen dargestellt. Swade fühlt sich damit offenbar unbehaglich und ist vielleicht verärgert über Babbages Angriffe auf die englische Wissenschaft in dessen Schrift Reflections on the Decline of Science in England von 1830 und anderswo.

Swade ist ein wichtiger Mann in dem in den 1970er Jahren gegründeten ‚Informationszeitalter-Projekt‘, wie man es in Britannien nennt, worüber wir mehr herausfinden müssen. Er verwickelt sich jedenfalls in eine, wie ich finde, Scheindebatte darüber, ob der moderne Computer Babbage viel verdankt oder nicht. Ich sage ‚Scheindebatte‘, weil Babbage selbst nach Darstellung in diesem Buch grundlegende Beiträge in wichtigen anderen Bereichen gemacht hat, etwa bei Werkzeugmaschinen, der Industrieherstellung, der Technikentwicklung usw. Offenbar ist er bis heute jemand von beträchtlicher Bedeutung in der derzeitigen britischen Diskussion über die Zerstörung der realen Industrie – den Post-Third Way.

Ich war auch darüber erfreut, daß in dem Buch Darwin, T. Huxley u.a. gar nicht erwähnt werden, da fast jedes Buch über ‚englische Wissenschaft‘ heutzutage von diesen Leuten ausgeht.

Ich hoffe jedenfalls, daß Du es interessant findest. – Mark“

Ich fand es interessant: Damals und, wie Sie sehen werden, auch heute.

Seither hat sich eine neue Generation junger Erwachsener als bedeutsame Kraft im politischen Leben herausgebildet, wodurch sich hoffentlich ein neues Fundament für die Führung unserer Gesellschaft im kommenden halben Jahrhundert oder länger aufbauen läßt. Das Hauptargument, das ich in der Buchbesprechung machte, sollte deswegen hier wiederholt werden, allerdings mit dem zusätzlichen Bezugsrahmen, der sich mit dem neuen Wissenschaftszugang deckt, mit dem sich die aufstrebende Erwachsenengeneration um die LaRouche-Jugendbewegung (LYM) beschäftigt.

Angesichts des heutigen Ausmaßes der weltweiten politischen Krise muß jedoch darauf gedrungen werden, daß wir dabei so unnachgiebig wie nötig vorgehen, um die Menschheit vor einer der heute weitverbreiteten und verheerendsten Betrügereien zu schützen, dem Irrglauben der sogenannten „Informationstheorie“, den wir auf den folgenden Seiten untersuchen wollen.

Wenn ich vom Betrug der „Informationstheorie“ spreche, möchte ich vor allem den zerstörerischen Effekt auf den Geist und auf die Weltwirtschaft hervorheben, der durch den verbreiteten Einfluß dieses pseudowissenschaftlichen Dogmas bewirkt und unter verschiedenen Bezeichnungen von Leuten wie Bertrand Russell, Norbert Wiener und John von Neumann verbreitet wird. Diese Herren hängen einem Kult an, der sich in solchen Formen des Aberglaubens wie von Neumanns „künstlicher Intelligenz“ ausgebreitet hat, wobei dieser gleiche Kult auch in Veröffentlichungen von Leuten wie Marvin Minsky und Noam Chomsky unter Federführung des MIT-Forschungslabors für Elektronik (RLE) auftaucht. Diese verquere Ideologie, die in den USA der 1940er Jahre als „Kybernetik“-Projekt von Organisationen wie der Josia Macy, Jr. Foundation eingeführt wurde, ist wichtiger ideologischer Bestandteil der Methode, mit der sich die einst mächtige amerikanische Wirtschaft in der Zeit von 1968 bis heute systematisch selbst zerstört hat.

Der Begriff „Intelligenz“, wie er von diesen postmodernistischen Ideologen mißbraucht wird, ist ein gezieltes Täuschungsmanöver. Dahinter steht die Absicht der Kreise um Bertrand Russell und dessen Gefolgsleuten Norbert Wiener und John von Neumann sowie auch der erbärmlichen Margaret Mead, um die Welt des US-Präsidenten Franklin Roosevelt zu zerstören. Dies war und bleibt ein Schwindel, der ausgerottet werden muß, damit nicht das sich ausbreitende Unkraut dieses Schwindels das Denken einer viel zu leichtgläubigen Menschheit weiter verkrüppelt, die dann selbstverschuldet einem drohenden neuen dunklen Zeitalter entgegenginge – vergleichbar mit dem finsteren Zeitalter, das Mitte des 14. Jahrhunderts fast ein Drittel der europäischen Bevölkerung hinwegraffte.

Am besten läßt sich das Thema, das ich hier zur Diskussion gestellt habe, im Wissenschaftsfach der physischen Ökonomie behandeln, worin meine besondere Fachkenntnis in langfristiger Wirtschaftsprognose auf der Welt heute nachweislich herausragt. Als ich 1948 den zentralen Irrtum in der Argumentation erkannte, die Prof. Norbert Wiener in seinem Buch Cybernetics präsentierte, führte mich dies direkt zu jenen Nachforschungen, die mich jene eigenen Entdeckungen machen ließen, die ich dem Bereich von Leibniz’ Wissenschaft der physischen Ökonomie hinzufügte. Was mich 1948-1953 zu meinen eigenen wirtschaftswissenschaftlichen Entdeckungen in einem Teilbereich der physischen Ökonomie antrieb, war die Erkenntnis dieses Grundirrtums, den Norbert Wiener und John von Neumann, ganz im Sinn von Bertrand Russell, zur Grundlage ihrer abwegigen Auffassung von der eigentlichen Natur des Menschen machten.

Um mit der weitgehenden Unkenntnis und Verwirrung über diesen Gegenstand aufzuräumen, müssen wir hier zunächst einige grundlegende Elemente über die Ursprünge des modernen elektronischen Digitalcomputers klarstellen, der einerseits zwar ein integraler Bestandteil des heutigen Lebens ist, aber andererseits völlig verdreht dargestellt wird als potentielles oder gar wirkliches Medium „künstlicher Intelligenz“. Auf diese Weise wurde der Computer zu einem Tempel der Anbetung für die Anhänger eines modernen sophistischen Kults erhoben – der radikal reduktionistischen, logisch-positivistischen Sophistik der sogenannten „Informationstheorie“.

Ich habe mich dazu früher und in den letzten Jahren mehrmals geäußert. Hier möchte ich den entscheidenden Punkt aus neuer Sicht wiederholen und einige Punkte hinzufügen, die unter anderem für die Erstellung realwirtschaftlicher Animationen wichtig sind, woran derzeit gearbeitet wird.

1. Die Geburt des modernen Computers

Die Geschichte von Charles Babbages wichtigsten Entdeckungen, aus denen sich die spätere Entwicklung digitaler Computersysteme ergab, läßt sich folgendermaßen zusammenfassen.

Die entscheidenden Stränge der modernen Naturwissenschaft, in denen sich die gültigen Strömungen der modernen europäischen Wissenschaft entwickelten, gehen auf die Begründung dieser modernen experimentellen Naturwissenschaft durch Kardinal Nikolaus von Kues in seiner Schrift De Docta Ignorantia im 15. Jahrhundert zurück.3 Diese Entwicklung zeigte sich zeitgleich auch in wichtigen Entdeckungen durch Zeitgenossen des Cusanus wie Filippo Brunelleschi, der beim Bau der Kuppel der Kathedrale von Florenz die Kettenlinienfunktion anwendete, sowie bei ausgesprochenen Cusanus-Anhängern wie Leonardo da Vinci und Johannes Kepler. Der Cusanus-Schüler Leonardo da Vinci, der das Prinzip des modernen Webstuhls erfand, leistete damit einen besonderen Beitrag, der in diesem Fall über Babbages Verwendung des Lochkartensystems der Webmaschine von Joseph-Marie Jacquard zur Entwicklung der Computerprogrammierung führte.

Die Entwicklung wissenschaftlicher Rechenmaschinen, die dann zum elektronischen Universalcomputer des 20. Jahrhunderts führte, begann zunächst mit dem Entwurf einer solchen Maschine durch Johannes Kepler, der diese als Hilfe bei seinen astronomischen Berechnungen brauchte. Zweitens, eine Kopie der von Kepler beschriebenen Maschine wurde von Blaise Pascal entworfen. Drittens, Pascals Arbeit war der Ausgangspunkt für die damals revolutionäre technologische Entwicklung eines ersten wissenschaftlichen Universalrechners durch Gottfried Wilhelm Leibniz. Viertens, der Entwurf für den mechanischen Vorläufer des modernen Digitalcomputers war vor allem ein Ausdruck des Einflusses von Leibniz auf Babbages Erfindung eines mechanischen Modells für den modernen elektronischen Computer.

Damit schließt sich der Kreis zu Keplers Astronomie: Nach eigener Darstellung wurde Babbage zu seiner Entdeckung angeregt durch seine lange enge persönliche Beziehung zu Sir John Herschel, dem führenden britischen Astronomen dieser Zeit, sowie zu den Kepler- und Leibniz-Anhängern unter seinen persönlichen Bekannten auf dem europäischen Kontinent, darunter der Wissenschaftler Alexander von Humboldt, der nicht nur in Deutschland, sondern auch in den Kreisen der Ecole Polytechnique von Monge und Carnot in Frankreich wirkte.

In diesem historischen Kontext, in den der wachsende Einfluß von Carl F. Gauß’ revolutionären Entdeckungen in der Astronomie fiel, war Babbages enge persönliche Beziehung zu dem Sohn des berühmten Astronomen Friedrich Wilhelm Herschel von entscheidender Bedeutung, um Babbage dazu zu bringen, an Entwürfen für seine mechanischen Rechenmaschinen zu arbeiten.4 Er reagierte damit auch auf das ständige Problem bei der modernen Astronomie: Die mühevolle Arbeit zur Erstellung genauer arithmetischer Tabellen – insbesondere seit den Bemühungen Tycho Brahes und des ihn überragenden Genies, Johannes Kepler. Abgesehen davon, daß Babbage den Nutzen von Jacquards Lochkartensystem als wichtigen Ansatz zum variablen Programmieren seiner Rechenmaschine erkannte, war aber der Kern der Entdeckung, die als Modell für den Entwicklungsansatz diente, der in modernen Rechenmaschinen verwendet wird, im wesentlichen Babbages eigene – entgegen Swades Sophistereien.

Wie wichtig es für die Wissenschaft war, solche gewaltigen Berechnungen anzustellen, war bereits daran deutlich geworden, wie Kepler die Fehler bei seinem Vorgänger Tycho Brahe erkannte und behandelte. Nachdem Aristarch von Samos (um 250 v. Chr.) mit der von Thales u.a. verwendeten Methode der Sphärik – der Untersuchung von Sonnen- und Mondfinsternissen – das heliozentrische Prinzip in der Astronomie bewiesen hatte, hat Kepler nicht nur die Sichtweise des Aristarch wiederbelebt, sondern mit Hilfe der Stellung von Sonne, Erde und Mars eine geringfügige Abweichung in den Umläufen des Sonnensystems festgestellt. Diese Abweichung machte eine Abänderung von Brahes Beobachtungsdaten notwendig, und das gelang mit einer so großen Genauigkeit, daß dadurch nicht nur die scheinbare Anomalie der Marsbahn geklärt werden konnte, sondern auch die elliptische Umlaufbahn der Erde selbst bewiesen wurde. Keplers Methode erfuhr einen zweiten, eindrucksvollen Beweis, als Carl F. Gauß den von Kepler vermuteten „Asteroidengürtel“ aufzeigte, ein Beweis, der in den Kreisen von Herschel und Babbage schnell die Runde machte.

Mit dieser Herausforderung sahen sich Babbage und sein Freund Herschel durch die Erkenntnisse von Gauß konfrontiert. Nach Keplers Erkenntnissen bis hin zu Gauß’ großartiger Entdeckung des Asteroidengürtels wurden umfangreiche Arbeiten zum Auffinden und Überprüfen von Daten obligatorisch. Die sich stellenden Probleme waren grundsätzlich physikalisch-geometrischer Natur, keine arithmetischen oder einfache algebraische Fragen. Die Krümmungen mußten genau vermessen werden, was umfangreiche Berechnungen auf Grundlage wiederholter Beobachtungen erforderlich machte, Beobachtungen, die ihrerseits mit größtmöglicher Präzision durchgeführt werden mußten. Zusätzlich brachten Babbage die typischen Fehler jener, die mit diesen Berechnungen beauftragt waren, dazu, eine Maschine zu entdecken, die die damals nicht unerhebliche menschliche Fehlerquote bei der Erstellung astronomischer Tabellen reduzieren konnte.

In den vernünftig geführten Debatten über die Richtigkeit von Babbages Vorhaben bzw. seiner Maschine kamen gewöhnlich die praktischen Probleme in den Produktionsmethoden des 19. Jahrhunderts und nicht so sehr wirkliche Grundfehler in Babbages Absicht zum Ausdruck. Die tatsächlichen Schwierigkeiten lagen in den praktischen Beschränkungen, im damaligen England eine nach Babbages Vorstellungen entworfene Maschine zu bauen. Die erforderliche Präzision der damaligen Werkzeugmaschinen war einfach nicht entwickelt genug. Vor allem dieser praktische Faktor hat den Bau einer vollwertigen Differenzmaschine nach Babbages Plänen verzögert. Wie spätere Entwicklungen zeigten, waren lediglich qualitative Verbesserungen in der Produktionstechnologie erforderlich, um den tatsächlichen Bau von Maschinen nach Babbages Entwürfen zu ermöglichen, was an den einzelnen Entwicklungsschritten der sogenannten Hollerith-Maschinen deutlich wurde, die der Entwicklung von elektronischen Digitalcomputern vorangingen.

Der Autor Swade ergeht sich in dem sophistischen Anschein, diese Frage zu diskutieren: Wer unter den verschiedenen bekannten Rivalen und angeblichen Anhängern von Babbages Plänen hatte behauptet oder bestritten, tatsächlich Kenntnisse über Babbages Pläne zu haben? Diese von Swade aufgeworfene Frage ist das beste Beispiel für eklatante Sophisterei.

Bei solchen Fragen mögen die Tatsachen für sich selbst sprechen. Die einzige ehrliche Frage lautet, ob Babbage dem gleichen Prinzip folgte, auf dem kompetente moderne Universalrechenmaschinen basieren. Um die Frage zu beantworten, wie sich Babbages Entdeckung vollzog, wissen wir, daß Babbage sich von Gauß’ jüngst bekannt gewordener Entdeckung der Asteroidenbahnen hat leiten lassen und daß diese Leistung ein entscheidender Beweis für die Methode Keplers gegen die Anhänger Galileos und der Newtonianer war; deswegen muß man davon ausgehen, daß Babbage und sein Freund Herschel Überlegungen in diesem Zusammenhang angestellt haben. In diesem Licht muß der Auslöser für Swades sophistische Ausflüchte gesehen werden, wie es auch aus Mark Burdmans Nachricht an mich hervorgeht: Bis heute hält die offizielle britische Feindseligkeit in der Tradition der Londoner Newcomen Society gegen Babbages Anteil an der Cambridge-Schrift von 1811 „D-ism and Dot-age“ und – wie Swade selbst andeutet – gegen Babbages eigene Schrift Reflections on the Decline of Science in England an.

Wenn man heute erwähnt, daß Charles Babbage im Design von jedem kompetent funktionierenden modernen Digitalrechner steckt, hat dies die spezifische bleibende Bedeutung, daß es vom Grundkonzept her keinen magischen Unterschied zwischen Babbages ursprünglichem Konzept einer zukünftigen Rechenmaschine und den modernsten solchen elektronischen Anlagen gibt. Nur die Entwicklungen, Anwendungen und Implikationen der Elektronik sind neu; alles übrige, der Kern der Sache, läßt sich auf Babbages Konzepte zurückführen.

Die Arbeitshypothese im vorliegenden Bericht ist, daß alles, was prinzipiell an Babbages eigener Entwicklung mangelte, notwendigerweise auch am Grundkonzept jedes heute verwendeten digitalen Computersystems mangelt.

Diese Begrenzung des Computerdesigns ist damals wie heute kein Fehler an sich. Gute, arbeitsfähige Computer führen in ihrem gewöhnlich anfälligen kurzen „Leben“ die Befehle aus, die ihnen gemeinsam von menschlichen Designern, Herstellern und Benutzern eingegeben wurden. Das Problem von Computern, das hier untersucht werden soll, ist kein Fehler in der ursprünglichen Konzeption des digitalen Computers selbst; der Fehler, der behoben werden muß, liegt vielmehr in der törichten Vorstellung eines Mannes, dessen Bewunderung für eine Schaufensterpuppe ihn dazu bringt, der armen Puppe Intimitäten anzutragen – und die Arme vielleicht zu verdreschen, wenn sie nicht mit der Begeisterung reagiert, die der verzückte Herr verlangte.

Swades Sophistereien

Swades Inkompetenz zeigt sich insbesondere darin, wie er Babbages Urheberansprüche auf die Grundzüge des Digitalcomputers abzuwägen vorgibt. Dies spricht stark dafür, daß Swade von den wichtigen naturwissenschaftlichen Grundfragen des 17. bis 19. Jahrhunderts keine Kenntnis hat oder (kurz gesagt), sich aus politischen Gründen lieber den Anschein gibt, von diesen Fragen nichts zu wissen. Wenn man einmal Unsinnsmaschinen wie die „Rube-Goldberg-Erfindungen“ beiseite läßt, geht es beim – mechanischen oder elektronischen – Digitalcomputer darum, daß auf der einen Seite Kepler, Leibniz, Gauß, Riemann u. a. und auf der Gegenseite die Empiristen und Positivisten wie Descartes, Newton, D’Alambert, de Moivre, Euler, Lagrange, Cauchy, Kelvin, Clausius, Grassmann, Helmholtz u.a. stehen.

Beim Computer dreht sich die Frage, wie sie sich in den pathologischen Argumenten Russells, Wieners, von Neumanns, Minskys, Chomskys usw. ausdrückt, darum, wie es kam, daß de Moivre als erstem zugeschrieben wurde, „imaginäre Zahlen“ benannt zu haben. Auf diese Frage werden wir weiter unten zurückkommen. Für unseren unmittelbaren Zweck genügt hier der Hinweis, daß Swades Sophisterei über die Frage von Babbages Urheberschaft wohl eher mit seiner wissenschaftlichen Unbildung in Fragen der reduktionistischen Methode zu tun hat.

Über Babbages Erfindung selbst lassen sich vor allem zwei wichtige Dinge anmerken. Erstens ist sie eine echte, patentfähige Erfindung; aber man sollte sich darüber klar sein, daß – genausowenig wie ein Richter oder Monsanto ein Anrecht haben, als Gottheit betrachtet zu werden – es bei Babbages Entdeckung um keine Entdeckung eines grundsätzlich nicht patentierbaren Naturprinzips wie der Entdeckung eines genetischen Typs geht. Die gleiche Unterscheidung gilt für die betrügerischen Ansprüche Norbert Wieners und John von Neumanns, ein universelles physikalisches Prinzip entdeckt zu haben, das ihre betrügerischen Ansprüche auf Entdeckung ihrer jeweiligen nichtexistenten Prinzipien der „Informationstheorie“ als einer Form der „künstlichen Intelligenz“ bekräftigen soll.

Im Gegensatz zu den irregeleiteten Verehrern virtueller Kreaturen in Gestalt von Geschöpfen aus der Fantasiewelt von H.G. Wells’ Dr. Moreau, die im Grunde Geschöpfe sind, wie sie sich Wiener, von Neumann u. a. vorstellen, bleibt es eine entscheidende Tatsache, daß die menschliche Intelligenz Ausdruck eines tatsächlichen, genau bestimmten Prinzips des Universums ist. Dieses Prinzip schöpferischer menschlicher Intelligenz unterscheidet sich grundsätzlich von der Intelligenz von Menschenaffen oder der Ideologie bestimmter moderner „grüner“ Politiker, die heute arglistig mit dem Schicksal der Menschheit herumspielen. Anders als Minsky und Chomsky, die versucht haben, ihr kollektives Selbst zum Affen zu halten, können kein Tier und keine noch so elegante Maschine eine Qualität der Intelligenz an den Tag legen, die innerhalb dieser Artenzusammensetzung wirksam ist.5

Ich habe entsprechende Feststellungen zuerst bereits Anfang 1948 gemacht, als ich mir ein Besprechungsexemplar von Wieners Cybernetics ausborgte. Anfangs war das Buch teilweise ganz reizvoll. Die Steigerung von Produktionstechniken im Zusammenhang mit der Computertechnologie wurde in Teilen von Wieners Buch ansatzweise beschrieben. Doch so viel mir das Buch deswegen zunächst gefallen hat, ärgerte ich mich bald über den Sophismus der „Kybernetik“, die Wiener an ein eigentlich interessantes Argument anhängte: Die Vorstellung, daß menschliche Intelligenz auf eine Machsche Sophistik namens „Informationstheorie“ reduziert werden könnte. Von diesem Augenblick an reagierte ich auf das Buch gleichsam instinktiv mit dem Entschluß, die tödliche Bedrohung für die Menschheit aufzuzeigen, die in dem durchaus verführerischen Schwindel mit der „Informationstheorie“ des Radikalreduktionisten Wiener steckte.

Der Unterschied zwischen Mensch und Tier ist die Hauptfrage, um die es hier geht, die Frage nach dem Betrug, der in der Behauptung steckt, vermeintliche „Information“ und „künstliche Intelligenz“ seien grundlegende Kategorien des Daseins. Der sicherste Beweis für den Betrug in den Behauptungen Wieners, von Neumanns u.a. liegt jedoch darin, ein Prinzip wirklicher Kreativität aufzuzeigen, eines Prinzips, das in den Systemen einer reduktionistischen Mathematik nicht vorkommt, wie jenen des Sophisten Euklid oder denen der modernen Nachfolger des Euklid wie Descartes und der Anhänger von Sir Isaac Newton, Norbert Wiener und John von Neumann.

Computer und Wirtschaft

Der Digitalcomputer und lineares Programmieren sind in vielen führenden Wirtschaftshochschulen der ersten Nachkriegsjahrzehnte praktisch synonym geworden. Von meinem Standpunkt als physikalischer Ökonom besteht der wichtigste Nutzen moderner elektronischer digitaler Datenverarbeitungssysteme in der Anwendung des „linearen Programmierens“ beispielsweise für administrative Zwecke. Am bekanntesten hierfür sind die Beiträge von Prof. Wassilij Leontief zur analytischen Korrelation im statistischen Wirtschaftsberichtswesen für Sozialprodukt und Nationaleinkommen, um für die US-Regierung wichtige Daten zusammenzustellen.

Der kürzlich verstorbene Leontief, der unter dem Russen Kondratieff – berühmt für den Begriff der „Kondratieff-Wellen“ in der Technologie – ausgebildet wurde, hat wichtige Beiträge zur Entwicklung der nationalen Buchhaltungspraxis geleistet. Seine gesunde Herangehensweise unterscheidet ihn von der „Elfenbeinturm“-Schule des heutigen positivistischen Radikalismus. Nach meinem besten Wissen hat er jedoch die Dynamik eines tatsächlich nichtlinearen realwirtschaftlichen Prozesses nicht verstanden. „Dynamik“ verstehe ich hier im Sinne der pythagoräischen dynamis oder der Definition von „Dynamik“, die Leibniz als Lösung für die inkompetenten Schriften des Sophisten René Descartes auf dem Bereich der Naturwissenschaft darlegte.

Genau genommen wird lineares Programmieren immer versagen, wenn man es als Methode mittel- bis langfristiger Planung einsetzt. Da es grundsätzlich eine mechanistische Technik ist, ist es als Werkzeug zur Darstellung echter dynamischer Prozesse, die jede wirkliche Ökonomie auszeichnet, axiomatisch ungeeignet. Lineares Programmieren erklärt manchmal schlechte geschäftliche oder staatliche Managementpraktiken, was nützlich ist, aber da wirtschaftlicher Fortschritt grundsätzlich nichtlinear und dynamisch ist, kann man mit linearen Methoden nie einen erfolgreichen Wirtschaftsprozeß planen.

Die inhärente Begrenzung und potentielle Schwäche, die allen Formen des linearen Programmierens anhaften, besteht darin, daß die linearen Methoden quasi-cartesischer Mechanik zwar einige Effekte aufführen können, die bei der Anwendung eines neuen Prinzips auftreten, doch diese Methoden sind inhärent unfähig, den Veränderungsprozeß zu definieren, der zwei oder mehrere aufeinander folgende Phasenzustände einer Wirtschaft miteinander verbindet, welche sich durch die Anwendung einer Reihe physikalischer Prinzipien verändern.

Damit soll nicht gesagt werden, daß Leontiefs Arbeit inkompetent gewesen wäre; ganz im Gegenteil. Die Frage, die gestellt werden muß, lautet: kompetent für welche vorgesehene Aufgabe? Leontief selbst hat sich Ende der 1950er Jahre in seiner Auseinandersetzung mit den sogenannten „Elfenbeinturm“-Fanatikern um Tjalling Koopmans u.a. im Grunde genauso ausgedrückt.

Was Leontief gegen Koopmans u.a. vorbrachte, war schon damals eigentlich keine neue Frage. Schon Gottfried Wilhelm Leibniz hatte diesen wichtigen Streitpunkt angesprochen, als er auf die Arglist hinter René Descartes’ Versuch hinwies, eine formal mechanistische Erklärung von lächerlich einfachen, falschen Ansichten physikalischer Prinzipien zu finden. Dabei ging es um den Fehler, den die Verfechter der cartesischen und newtonischen Methode wie D’Alembert, de Moivre, Euler, Lagrange, Laplace und Cauchy begingen, als sie Leibniz’ Infinitesimalkalkül und das damit verwandte Grundprinzip von Leibniz’ Kettenlinien-Ansatz zu dem universellen Prinzip der geringsten Wirkung attackierten. Um diese Frage ging es auch Carl F. Gauß, der bereits in seiner Doktorarbeit 1799 D’Alembert u.a. angriff.

Das charakteristischste Merkmal jeder wirklichen Ökonomie ist ein willentliches, nichtlineares, dynamisches Wirkprinzip, das bei keiner einzigen bekannten lebenden Art vorkommt, abgesehen von den genau definierbaren kreativen Fähigkeiten des menschlichen Geistes. Dieses Wirkprinzip äußert sich als Veränderungen in der Ökonomie infolge der Entdeckung und Anwendung eines universellen Prinzips oder entsprechender Prinzipien. In jeder kompetenten Naturwissenschaft äußert sich das gleiche Unterscheidungsmerkmal als ursprüngliche Entdeckung, die sich durch geeignete Tests als universelles physikalisches Prinzip erweist.

Diese Unterscheidung ist entscheidend wichtig, um den Ursprung der grundsätzlichen Inkompetenz aller Versuche zu verstehen, die gewöhnlich gelehrten und praktizierten Spielarten von Buchführung oder Ökonomie als wissenschaftlich hinzustellen. Bei der ganzen Kontroverse geht es um folgende wichtige Frage.

Während es bei allen niederen Lebensformen, namentlich auch den Tieren, eine Grenze für die Zahl von Lebewesen gibt, kennt der Mensch keine solche Begrenzung. Wäre der Mensch eine Abart des Menschenaffen, läge das Bevölkerungspotential unserer Gattung in der Größenordnung von vielleicht einigen Millionen Lebewesen zu irgendeiner Zeit während der letzten ein oder zwei Millionen Jahre. Daß heute mehr als sechs Milliarden Menschen auf der Erde leben, und das auf einem höheren Niveau pro Kopf als in der Antike oder dem Mittelalter oder selbst in den jüngsten Jahrhunderten, ist Ausdruck eines Vermögens der menschlichen Gattung, das unter den Tieren fehlt.

Diese Auffassung von Vermögen steht in Zusammenhang mit dem Begriff dynamis der Pythagoräer und Platoniker in der antiken griechischen Kultur, aus der die größten Errungenschaften der europäischen Zivilisation hervorgegangen sind. Im antiken, voreuklidischen klassischen Griechenland war dynamis ein Prinzip der physikalischen Geometrie, nicht der heute gewöhnlich gelehrten Schulgeometrie. Die vorsophistische, antieuklidische Auffassung physikalischer Geometrie lehnte – im Gegensatz zu dem Sophisten Euklid – jeden Versuch ab, geometrische Zustandsformen als „selbstevident“ zu behandeln. Die konstruktive Verdoppelung des Würfels durch den Pythagoräer Archytas, die Konstruktion der Platonischen Körper durch die Kreise Platons und die späteren Entdeckungen des Pentagramma Mirificum durch Napier und dann Gauß sind Beispiele dafür, wie in der klassischen griechischen Wissenschaftstradition universelle physikalische Prinzipien durch Konstruktion im Medium einer synthetischen, physikalischen Geometrie definiert wurden, wie Bernhard Riemann später eine solche physikalische Geometrie entwickelte.

Das Maß für die Leistung einer physikalischen Ökonomie ist die Zunahme des Vermögens der Gesellschaft in diesem Sinne. Diese Zunahme ist eng verbunden mit der Entdeckung und Anwendung universeller physikalischer Prinzipien im Sinne der menschlichen Einwirkung auf die Natur und mit der Weiterentwicklung klassischer Kompositionsprinzipien, durch die über bewußtes soziales Handeln in der Gesellschaft – im Grunde wie durch naturgesetzliche Entwicklung – eine höhere Qualität der Zusammenarbeit entstehen kann.

Das Maß für die Leistung einer Wirtschaft liegt in der Ökonomie einer bestimmten Bevölkerung und Landfläche als Ganze, nicht in der Summe offenbarer Gewinne in nur einigen Teilen des Wirtschaftssystems. Deswegen können digitale Systeme zwar bestimmte Schatten einer an sich nichtlinearen Entwicklung messen, nicht aber die reale Entwicklung selbst.

Jede kompetente Wirtschaftswissenschaft muß deswegen eine Wissenschaft der physikalischen Ökonomie und kein monetäres System sein.

Monetäre Systeme, wie sie durch archäologische Funde im antiken Mesopotamien bis heute bekannt sind, basieren auf der Annahme, daß das Kennzeichen von Kulturen die einfache lineare Ansammlung von Dingen sei. Die modernen venezianischen und ähnlichen Lehren gehen genauso wie Adam Smith und seine Vorgänger davon aus, daß geheimnisvolle Wesen unter den Bodendielen des Universums agieren und mit gezinkten Würfeln bestimmen, welcher Bewohner oben reich und welcher arm gemacht wird, wer Herr und wer Sklave sein soll.

Da sich alle universellen physikalischen Prinzipien mathematisch als effiziente Funktion infinitesimaler Zahlen äußern, wie ich weiter unten zeigen werde, kann kein lineares System wie etwa die gängige Buchhaltungslehre die Rolle von „Investitionen“ in die Entdeckung und Anwendung physikalischer Prinzipien, wovon jede reale Verbesserung in der Wirtschaft pro Kopf und pro Quadratkilometer abhängt, wirklich erfassen.

Das relevante Merkmal des modernen Computers ist im Prinzip so alt wie die frühesten astronomischen Erkundungen des Menschen, besonders die Entwicklung einer wissenschaftlichen Methode zur Astronavigation entsprechend der ägyptischen Sphärik, die von den Pythagoräern und Platon übernommen wurde. Historisch dreht sich jedoch der moderne Plan zum Bau einer Universalmaschine als Hilfsgerät für schwierige Berechnungen um zwei qualitativ unterschiedliche Entdeckungen, die Entdeckung der universellen Schwerkraft, die besondere Leistung von Johannes Kepler, und die Entsprechung von Keplers Entdeckung durch Fermat, der das Prinzip des schnellsten Weges definierte.

Auf einer tieferen Ebene in der Geschichte der europäischen Zivilisation waren derartige Prinzipien in Form der beiden genannten Entdeckungen bereits spätestens seit den Forschungen über die sogenannte Sphärik von den Pythagoräern und Platon verstanden worden. Die Verwendung des physikalischen Prinzips der Kettenlinie durch Brunelleschi beim Bau der Kuppel der Kathedrale von Florenz und die Begründung der modernen experimentellen naturwissenschaftlichen Methode durch Nikolaus von Kues bildeten die Grundlage für die weiteren Arbeiten überzeugter Cusa-Anhänger wie Luca Pacioli und Leonardo da Vinci.

Auch wenn das entsprechende Konzept bereits vom Cusaner dargelegt wurde, hat dann erst Johannes Kepler als überzeugter Cusa-Anhänger den wichtigen Schritt zur Ausübung der modernen Naturwissenschaft und zur Entwicklung des modernen Universalcomputers getan.

Berücksichtigt man diese Einschränkungen, begründete Kepler (nicht Kopernikus und sicher nicht Galileo, der Scharlatan und Lakai des Venezianers Paolo Sarpi) die allgemeine Ausübung der modernen experimentellen Naturwissenschaft, wie sie grundsätzlich bereits von Nikolaus von Kues vorgegeben wurde, der die Entdeckung des Aristarch von Samos lange vor Kopernikus aufgriff. Was die Ursprünge des Computers angeht, muß verstanden werden, daß Kepler den ersten bekannten Schritt zur Herstellung eines Universalcomputers gemacht hat, der ihm dabei helfen sollte, die riesige Masse an Berechnungen zu verarbeiten, mit denen er die haarsträubenden Konstruktionen des römischen Gauners Claudius Ptolemäus lächerlich machte und die systemischen Fehler in Methode und Auffassung des Kopernikus und seines Vorgängers Tycho Brahe korrigierte. Diese Feststellungen sind extrem wichtig für jedes kompetente Verständnis der Rolle der modernen Naturwissenschaft in der Ökonomie und sind genauso wichtig, um bei der Entwicklung der modernen Rechenmaschine seit Kepler Mythos und Realität auseinanderzuhalten.

Keplers Entdeckungen bedingten umfangreiche mathematische Arbeiten, angefangen mit der Ergänzung von Tycho Brahes unfertigen Arbeiten und der Korrektur wichtiger Fehler in Brahes Unterlagen bis hin zur vollständigen Neufassung des Beobachtungssystems, das Brahe und andere zuvor entwickelt hatten.6 Bis vor kurzem war ein Großteil von Keplers Werk den heutigen Physikern, die durch den Galileo- und Newton-Kult geschädigt sind, mit einigen wenigen Ausnahmen, praktisch unbekannt; hingegen überwog unter den Verehrern Isaac Newtons eine gesäuberte Darstellung der Entdeckungen, die der Sophist Galileo Galilei verbreitet hatte. Diese Unkenntnis wichtiger Aspekte von Keplers Werk, eine Unkenntnis, die gefördert wurde, um das relativ populäre, synthetische Image von Isaac Newton zu erhalten, hat dem Wissen um selbst rudimentäre Fragen einer kompetenten modernen Naturwissenschaft und besonders einer Wissenschaft der physikalischen Ökonomie sehr geschadet. Wie das Beispiel von Keplers elliptischen Umlaufbahnen zeigt, sind die wichtigsten Fragen sehr grundlegend.

Es muß jedoch auch festgestellt werden, daß es bei dem Trugschluß, auf den man bei der Behandlung von Keplers Werk gewöhnlich stößt, darum geht, die Frage der Effizienz universeller physikalischer Prinzipien, wie der Gravitation, zu umgehen, indem man das tatsächliche Wirkprinzip durch die rein algebraischen Darstellung eines sichtbaren Effekts ersetzt. Im Extremfall dieser unhaltbaren reduktionistischen Methode wird die Idee des physikalischen Prinzips als solches eliminiert, indem man an die Stelle eines Wirkprinzips eine bloße mathematische Formel setzt.

Um die Hauptfragen, die ein vernünftiges Verständnis der Möglichkeiten und Begrenzungen des Digitalcomputers erfordern, darzustellen und zu lösen, ist es sehr nützlich, das Prinzip der Gravitation, wie es Kepler tatsächlich entdeckt hat, mit dem Grundprinzip einer kompetenten Wissenschaft der physikalischen Ökonomie zu vergleichen. Anders gesagt, man muß die physikalisch begründeten Beschränkungen, die dem modernen Universalcomputer innewohnen, und das Funktionsprinzip einer erfolgreichen physikalischen Ökonomie verstehen, wie es sich in der ontologisch aktualen (nicht imaginären) Form des Leibnizschen Infinitesimal ausdrückt, denn Leibniz’ ureigene Entdeckung des Infinitesimalkalküls schloß sich direkt an Keplers Entdeckung des Infinitesimals als funktionales Merkmal der Planetenbahnen an.

Computeranimationen

Die eben gemachte Unterscheidung spielt eine wichtige Rolle bei dem sehr sinnvollen Verfahren, das ich in den Umgang unserer Vereinigung mit Wirtschaftsfragen eingebracht habe.

Im Rahmen meiner Berufsausübung als Wirtschaftsberater in den 1950er Jahren hatte ich es als notwendig empfunden, den Begriff Dynamik im Leibnizschen Sinne in die normale Wirtschaftspraxis aufzunehmen. Meine Sicht dynamischer Wirtschaftsmodelle, im Gegensatz zu mechanistischen, linearen Modellen, läßt sich mit dem Konzept von Dynamik bei W.I. Wernadskij vergleichen, der damit die spezielle Chemie der Biosphäre definierte, wie ich 2005 in meinem Aufsatz „Wernadskij und das Dirichlet-Prinzip“ betonte.7

Das gleiche Prinzip gilt auch für die Musik, wie es der Dirigent Wilhelm Furtwängler mit seinem Begriff „Spielen zwischen den Noten“ verdeutlicht. Das Prinzip des pythagoräischen Kommas, das Johann Sebastian Bach auf die Methode des wohltemperierten Kontrapunkts anwendete, kommt hier auch in Betracht. In all diesen Bereichen – Ökonomie, Biogeochemie und klassische Polyphonie – haben wir es mit Phänomenen zu tun, die einer anti-euklidischen physikalischen Geometrie folgen. Das gleiche Prinzip hat Bernhard Riemann durch seine Begründung und Entwicklung einer explizit anti-euklidischen Geometrie in die moderne Physik eingeführt. Aus dieser physikalischen Geometrie sind alle Apriori-Annahmen von Definitionen, Axiomen und Postulaten verbannt. In ihr gibt es nur experimentell erwiesene universelle physikalische Prinzipien für die Wissenschaft, genauso wie auch für die klassische künstlerische Komposition und verwandte Bereiche.

In solchen anti-euklidischen Systemen, wie sie Riemann beginnend mit seiner Habilitationsschrift von 1854 darstellte, sind die einzigen erlaubten „Dimensionen“ universelle physikalisch-experimentelle Prinzipien. In dieser Hinsicht bedeutet Riemanns Habilitationsschrift eine Rückkehr zu dem Kernprinzip der Methode der Sphärik, wie sie von den Pythagoräern und Platon verwendet wurde. In einer physikalischen Ökonomie (d.h. einer Realwirtschaft im Unterschied zu einem rein monetär-finanziellen System) ist die Zunahme der von Norbert Wiener falsch benannten „negativen Entropie“ das eigentlich Wichtige.

Zum Beispiel habe ich in meiner Arbeit von 1948-1953, die mich soweit brachte, eine physikalisch-ökonomische Funktion als Riemannsche Funktion zu definieren, festgestellt, daß Wirtschaftsprozesse immer als physikalisch-ökonomische Prozesse aufgefaßt werden müssen, weswegen das Wirken monetär-finanzieller Systeme, wie oben schon erwähnt, vom Standpunkt eines physikalischen, nichtmonetären Prozesses beurteilt werden müssen. Das bedeutet, man muß alle wichtigen physikalischen Prinzipien menschlicher Betätigung als Prozeß behandeln, der nach seiner relativen, physikalischen „Anti-Entropie“ bewertet wird. Das bedeutet, die Entwicklung des Universums zu einem höheren Organisationszustand, wie es an der Entstehung des Sonnensystems aus der Sonne deutlich wird, äußert sich dadurch, daß der Mensch weitere universelle physikalische Prinzipien entdeckt und umsetzt. Daraus ergibt sich im Grunde die physikalische Bedeutung eines Riemannschen hypergeometrischen Dynamikbegriffs.

[…]

Wenn ich auf Computer-„Animationen“ verweise, möchte ich vor allem den Effekt betonen, ein oder mehrere physikalische Prinzipien dem dargestellten Wirtschaftsprozeß hinzuzufügen oder daraus zu entfernen. Man sollte dabei im Kopf behalten, daß analytisch nützliche Computeranimationen konzeptionell aus der Zeitrafferphotographie hervorgegangen sind, besonders aus dem Einsatz von Techniken, die dem Beobachter geistig helfen, ein bestimmtes, „absichtliches“ Bewegungsmuster zu sehen, etwa das Wachstumsmuster eines Unkrauts im Vergleich mit dem anderer Pflanzen. Ich habe generell dazu ermuntert, Computeranimationen einzusetzen, aber ich habe entsprechend hinzugefügt, daß man vor allem Beispiele authentisch „nichtlinearer“ Funktionen, wie jene bei der Hinzufügung oder Entfernung eines angewandten physikalischen Prinzips im dargestellten Prozeß, entdecken und abbilden sollte.

2. Was genau heißt „nichtlinear“?

Es mag vielleicht seltsam klingen, aber im Rahmen physiologischer Begrenzungen tendieren wirkliche Wissenschaftler, im Gegensatz zu digitalen Computern, dazu, mit zunehmendem Alter bessere, wenn auch langsamere Denker zu werden. Das gleiche trifft im Grunde auch auf klassische Künstler zu, nur daß ihre nachlassende Seh- und Hörkraft ihr sinnliches Erleben einschränkt; ähnliche Alterserscheinungen beeinträchtigen auch die Möglichkeit von Wissenschaftlern, bestimmte aktive Versuchsarbeiten selbst durchzuführen. Die tiefere Ursache für diese offenbare Anomalie in der menschlichen Physiologie ist der Umstand, wie W.I. Wernadskij in seinem letzten Lebensjahrzehnt feststellte, daß der Mensch einem qualitativ höheren Seinsbereich als alle Tiere angehört, wie es bereits in der mosaischen Schöpfungsgeschichte festgesetzt ist. Der Mensch ist sterblich wie die Tiere und wird mit der Zeit gebrechlich; aber der Mensch ist keine Maschine und auch kein Tier. Menschliche Kreativität ist keine Eigenschaft der Tiere; allerdings scheint menschliche Dummheit das Kriterium einer tierischen Eigenschaft zu erfüllen.

Anders gesagt, genauso wie lebende Prozesse chemische Eigenschaften aufweisen, die es im abiotischen Verhalten der gleichen Elemente nicht gibt, unterscheidet sich anlog der menschliche Geist absolut vom Bereich der tierischen Ökologie durch jene kreativen (d.h. noetischen) Fähigkeiten, die nur dem Innenleben des menschlichen Geistes eigen sind. Die Effekte dieser noetischen Fähigkeiten lassen sich nicht direkt von einem Menschen zum anderen kommunizieren, als wenn sie „verdrahtet“ wären, sondern nur durch ein „Resonanz“-Prinzip replizieren, wie es durch die Ironie in der klassischen Poesie oder in Wilhelm Furtwänglers Methode des „Spielens zwischen den Noten“ zum Ausdruck kommt.

Wie es Wernadskijs Konzept der Noosphäre implizit verlangt, sind die menschlichen kognitiven Fähigkeiten, die sich in ursprünglichen Entdeckungen universeller physikalischer Prinzipien wie Keplers Entdeckung der Gravitation oder Archytas’ Verdoppelung des Würfels durch rein physikalisch-geometrische Konstruktion zeigen, Ausdruck eines universellen physikalischen Prinzips, im gleichen Sinn wie es in der Chemie lebender Prozesse Vorgänge gibt, die bei gleichen Elementen unbelebter Prozesse nicht vorkommen. Wir haben es somit mit eigenständigen, aber sich wechselseitig beeinflussenden physikalischen Phasenräumen zu tun.

Kognitive Kreativität, wie sie das menschliche Individuum vom Tier unterscheidet, ist Ausdruck eines spezifischen physikalischen Prinzips, aber eines Prinzips, das den Phasenraum bloßen Lebens übersteigt, genauso wie Leben ein besonderer universeller physikalischer Phasenraum im Unterschied zum nachrangigen unbelebten Phasenraum ist. Der physikalisch wirksame Einfluß des höheren Prinzips menschlicher Kreativität, das im klassischen Griechenland als dynamis bekannt war, auf den Bereich des Lebens regt das lebende menschliche Gewebe zu dynamischen Vorgängen in Kategorien an, die man bei Archytas, Platon, Kepler u.a. kennt, die aber nicht bei den niederen Lebewesen vorkommen.

Sozusagen auf der „Schattenseite“ kann der menschliche Geist aber auch durch den Mißbrauch seiner kreativen Fähigkeiten abgerichtet werden, so wie es der olympische Zeus von den sterblichen Menschen verlangte. Er wollte, daß der Mensch seine kreativen Fähigkeiten unterdrückt, genauso wie der Sophist Euklid mit den früheren Entdeckungen physikalischer Prinzipien der Geometrie durch die Pythagoräer und Platon umging. Die gleiche Tendenz erlebt man im philosophischen Reduktionismus wie dem Empirismus und dem Machschen Positivismus generell, obgleich diese früheren Irrlehren von D’Alembert, de Moivre, Euler, Lagrange u.a. längst in Gauß’ Doktorarbeit von 1799 und auch die verwandten Fehlschlüsse in Immanuel Kants Kritiken und in Hegels römischem Rechtspositivismus entlarvt worden sind. Machs verderblicher Einfluß auf das menschliche Denken kommt vor allem bei Sigmund Freud und in den wilden, arglistigen Angriffen auf Max Planck durch die Anhänger des Mach-Kults während des Ersten Weltkriegs in Deutschland zum Ausdruck. Gestörte Persönlichkeiten wie Freud und einige unter den Machianern haben ihre menschlichen Fähigkeiten nicht völlig verloren, denn Freud beispielsweise hatte brillante Momente; diese Fähigkeiten waren jedoch weitgehend unterdrückt, und dabei äußerte sich das kreative Potential oftmals in Form reduktionistischer Perversionen.

Die Tatsache, daß unser Universum aus drei eigenständigen, aber sich wechselseitig beeinflussenden Prinzipien besteht, ist bereits die Grundlage für einen ontologischen Beweis, daß die Wechselbeziehung unter den drei Kategorien die Existenz eines höheren Prinzips, eines höheren „vierten Bereichs“ zeigt, unter dem die drei jeweils eigenständigen Phasenräume zu einem einzigen dynamischen System integriert werden.

Aus diesen Gründen, wie sie von Platon in seinem Parmenides-Dialog dargestellt wurden, lassen sich die Früchte dieser kreativen Fähigkeiten weder im Rahmen einer arithmetischen noch einer euklidischen Geometrie mitteilen. Wenn es um Kreativität geht, scheitert jede deduktiv-induktive Methode vollständig.

Der Mensch hat deshalb die Eigenschaft potentieller Unsterblichkeit, die sich bei keiner niederen Lebensform findet. Wie Nikolaus von Kues betonte, mögen Tiere nur durch ihre Teilhabe an einer eindeutig höheren Seinsform, der des Menschen, bestenfalls eine angedeutete Unsterblichkeit erreichen, da die menschliche Unsterblichkeit in der Teilhabe an einem höheren „vierten Bereich“, dem Universum des Schöpfers, liegt.

Die gegenteilige Sichtweise, wie die sophistische Perspektive in Euklids Elementen, beschreibt im wesentlichen eine lineare Flat-Earth-Universalität des Parallelenaxioms. Ersetzt man das Parallelenaxiom mit einem nichteuklidischen Axiom, verbessert sich zwar der Anschein, aber der Tote wird dadurch nicht zum Leben erweckt. Entfernt man die willkürlichen Annahmen der euklidischen oder anderen „Flat-Earth“-Geometrien, bleibt für die Wissenschaft nur ein dynamisches System, ein endliches und selbstbegrenztes Universum übrig, das im Grunde eine Riemannsche Hypergeometrie ist.

Dadurch ergeben sich die folgenden Parameter, um Russells, Wieners und von Neumanns radikal positivistische Tiraden anzugehen.

Um das Argument zusammenzufassen, das ich zu Beginn dieses Kapitels angeführt habe: Der qualitative Unterschied zwischen Mensch und Tier zeigt sich in Wernadskijs Vorstellung einer qualitativen, universellen Unterscheidung von drei wahrnehmbaren Seinsformen im Universum: den unbelebten Prozessen, dem Bereich lebender Prozesse (der Biosphäre) und dem dritten, höheren Bereich der Menschheit, den Wernadskij die Noosphäre nennt.

Wie Wernadskijs biogeochemische Arbeiten zeigen, ist die Grenze zwischen dem unbelebten Bereich und dem Bereich lebender Prozesse und ihrer Fossilien Ausdruck eines universellen physikalischen Prinzips. Genauso gibt es eine grundsätzliche Barriere, die den Menschen über die Tiere erhebt. Der Mensch ist die einzige Gattung, die ihre potentielle relative Bevölkerungsdichte pro Quadratkilometer Erdoberfläche willentlich erhöhen kann. Diese Unterscheidung ist die einzige kompetente Grundlage, um die Qualität wirtschaftlicher Praxis zu definieren und zu bewerten.

Wie ich bereits in meinem Aufsatz „Wernadskij und das Dirichlet-Prinzip“ dargestellt habe, vervollständigte Wernadskij in seiner Arbeit im letzten Jahrzehnt seines Lebens den Beweis, daß das physikalische Universum, wie wir es erleben, in drei strikte, aber sich dynamisch gegenseitig beeinflussende Bereiche unterteilt ist: Das Unbelebte; das Leben und seine spezifischen Produkte; und die kognitiven Prozesse, die den Menschen in einen höheren, dritten Bereich außerhalb des Bereichs der anderen lebenden Prozesse versetzt.

Wernadskij definierte diese Unterschiede dynamisch, so wie Leibniz den Begriff „Dynamik“ in die moderne Physik einführte. Anstatt Vorgänge im erweiterten, aber immer noch euklidischen Bereich René Descartes’ und seiner empiristischen Anhänger in Britannien und auf dem Kontinent zu lokalisieren, ist Wernadskijs Dynamikbegriff – genauso wie der von Leibniz – ein getreues Abbild der Sphärik, die mit den wissenschaftlichen Entdeckungen der Pythagoräer und Platons verbunden ist. Wirkliche universelle Vorgänge ereignen sich in einer anti-euklidischen physikalischen Geometrie, wie dies in der modernen Naturwissenschaft am besten in der Arbeit Bernhard Riemanns deutlich wird.

Wie ich zu Beginn dieses Kapitels feststellte: Wer seinen Geist insbesondere für neue schöpferische Erkenntnisse einsetzt, die wir mit Entdeckungen universeller physikalischer Prinzipien oder ähnlichem verbinden, und sich nicht mit deduktiv-induktiven Belegen niedriger Ordnung abgibt, wird seine Geisteskräfte mit der Zeit eher stärken, im Vergleich mit jenen, deren geistige Gewohnheiten im Laufe der Zeit immer weiter „verknöchern“. Erscheinungen, die mit dieser Unterscheidung einhergehen, lassen sich nicht im Rahmen der Biologie als solcher ausfindig machen, sondern zwingen uns dazu, die Tatsache zu berücksichtigen, daß kognitive Vorgänge, wie sie mit Entdeckungen wissenschaftlicher Prinzipien einhergehen, eine Kraft ausdrücken, die von einer höheren Ordnung ist als die Biologie und somit dynamisch auf diese einwirkt.

In ihrer Intention entspricht diese Unterscheidung dem Auftrag einer höheren Mission an den Menschen in der Schöpfungsgeschichte (Genesis 1). Keine Tierart kann ihre potentielle relative Bevölkerungsdichte erhöhen; nur der Mensch kann dies mit Hilfe seiner höheren kognitiven Funktionen, durch die die Entdeckung und Anwendung universeller physikalischer Prinzipien höherer Ordnung in nicht degenerierten Kulturen möglich sind, die für die satanische Figur des olympischen Zeus aus Aischylos’ Der gefesselte Prometheus nur Verachtung übrig haben.

Diese dynamischen Verstandeseigenschaften zeichnen die besten Denker im klassischen Griechenland aus, darunter Thales, Heraklit, Solon, Archytas, Sokrates und Platon, die aber bei ihren namhaften Widersachern fehlen. Der Begriff „dynamisch“, wie ihn Leibniz im Gegensatz zu Descartes und dessen Anhängern verwendet, ist ein moderner Ausdruck, der sich von dem Begriff dynamis ableitet, wie ihn die Pythagoräer des klassischen Griechenlands verwendeten, und er hat heute auch eine ontologische Assoziation zu Platon in Hinblick auf die Verwendung einer physikalischen und nicht nur einer rein formalen Geometrie.

Zur weiteren Klärung wollen wir jetzt beschreiben, welche Bedeutung der Begriff „Dynamik“ hat, wenn er im Gegensatz zu den radikal reduktionistischen Systemen heutiger empiristischer und positivistischer Ideologien erscheint. Damit wollen wir den Leser mit einer intellektuellen Landkarte der Inhalte versorgen, die auf den folgenden Seiten diskutiert werden sollen.

Keplers selbstbegrenztes Universum

Das Universum von Riemann und Einstein beispielsweise ist ein dynamisches System der Art, das sich am besten als endlich und selbstbegrenzt beschreiben läßt, wie ich es oben getan habe. Das bedeutet, daß etwa die Schwerkraft, die einzig von Johannes Kepler entdeckt wurde (und nicht von den Sophisten Galileo und Newton), ein universelles physikalisches Wirkprinzip ist. Anders gesagt, ein Wirkprinzip so ausgedehnt wie das Universum, und das in einem Universum, das nicht weiter ausgedehnt ist, als bis wohin das universelle Prinzip der Schwerkraft reicht. Unser Universum ist deshalb selbstbegrenzt und in diesem Sinn endlich. Seine Grenzen drücken sich in der wachsenden Ansammlung von Entdeckungen und Anwendungen universeller physikalischer Prinzipien durch den Menschen aus.

Jede Entdeckung, die die Anforderungen an ein universelles physikalisches Prinzip erfüllt, ist deshalb, wie ich gesagt habe, genauso ausgedehnt und begrenzt, wie die Schwerkraft als begrenzt definiert werden muß. Prinzipien, die dieser Anforderung genügen, beeinflussen einander universell, um jene normalerweise begrenzten Effekte zu erzeugen, die im Laufe der Entwicklung des sich erweiternden menschlichen Erfahrungswissens entdeckt werden.

Deshalb ist jede physikalische Aktion im Universum durch eine physikalische Geometrie definiert, die die universelle Wechselwirkung universeller physikalischer Prinzipien ausdrückt. Das Universum ist somit in diesem Sinne durchgängig dynamisch. Die nennbar verschiedenen Kategorien von Dynamik definieren die Trennung zwischen den ansonsten sich gegenseitig beeinflussenden Bereichen des Unbelebten, der Biosphäre und der Noosphäre. Die Wechselbeziehung zwischen diesen drei Bereichen definiert das Experimentierfeld des bekannten Universums als einheitliche Phasenräume.

Die Frage, die sich für das menschliche Wirken stellt, nimmt damit die Form an: Wie kann der Mensch mit Hilfe seiner Sinne mit Sicherheit wissen, daß es universelle physikalische Prinzipien gibt? Für die moderne Naturwissenschaft stellt Johannes Keplers Entdeckung der universellen Gravitation in meinen Augen die beste Wahl zur Darstellung eines universellen physikalischen Prinzips als eigentlich nichtlineare oder transzendentale Funktion der Art dar, die nicht nur Leibniz’ ursprüngliche Entdeckung des Infinitesimalkalküls, sondern auch die weitere revolutionäre Veränderung in der mathematischen Physik erforderlich machte, die Bernhard Riemann mit seiner vollständig anti-euklidischen physikalischen Geometrie ermöglicht hat.

Die wichtigste Errungenschaft Riemanns für die Naturwissenschaft insgesamt bestand darin, daß er über die Grenzen elliptischer Funktionen – auch über die Grenzen in Abels Arbeiten – hinausging, um die tieferen Implikationen aus Gauß’ flüchtiger Beschäftigung mit Hypergeometrien zu untersuchen und zu erarbeiten. (Damit möchte ich auch den Versuch zurückweisen, Riemann die Unterstützung für eine Entdeckung unterzuschieben, die der überführte Plagiator und Betrüger Cauchy aus einem Papier abgeschrieben hat, das er aus den Schriften des verstorbenen Niels Henrik Abel gestohlen hatte. Das gestohlene Papier tauchte nach Cauchys Tod in einem Katalog von Unterlagen auf, die in Cauchys Besitz sorgfältig aufbewahrt wurden.)

Man betrachte das Prinzip der Gravitation in diesem Lichte, eine Entdeckung, die einzig von Johannes Kepler gemacht wurde. Ich möchte an diesem Beispiel verdeutlichen, welches qualitative Ziel bei der Entwicklung von Animationen für die physikalische Ökonomie verfolgt werden sollte.

Es wäre falsch, Keplers Entdeckung so zu beschreiben, daß Planeten wie die Erde oder der Mars einer elliptischen Bahn im Sonnensystem folgen. In kompetenter Wissenschaftssprache müßte man sagen, das als Gravitation bekannte universelle Prinzip zwingt die Planeten wiederholt dazu, einer elliptischen Bahn zu folgen. Das Grundmerkmal dieses Vorgangs ließe sich an einer Tafel einfacher euklidischer Geometrie mit Hilfe von Nadeln und Fäden oder eines geeigneten Kegelquerschnitts darstellen. Doch diese Methoden haben mit dem ontologischen Charakter einer elliptischen Keplerschen Bahn nichts gemein. Solche primitiven Möglichkeiten sind typisch für den gewöhnlich unbedarften Studenten, wie man ihn unter den Anhängern von Descartes und Newton findet. Die korrekte Methode verlangt die Leibnizsche Formulierung eines ontologischen Infinitesimalkalküls.

Ein Gedankengang, der mit dieser korrekten Wissenschaftssprache übereinstimmt, brachte Kepler dazu, den zukünftigen Mathematikern zwei Aufgaben zu stellen, mit denen seine Entdeckung weiter vervollkommnet werden sollten. Dieser Gedankengang Keplers, der von Leibniz, Gauß und anderen bis hin zu Bernhard Riemann erfolgreich bewältigt wurde, ist wichtig, um die richtige Funktion von Animationen beim Studium der gesetzmäßigen Prinzipien zu verstehen, welche das Verhaltensmuster sämtlicher Volkswirtschaften bestimmen – ob die Regierungen dem zustimmen oder nicht.

Die zwei Aufgaben, die Kepler stellte, waren erstens, einen echten Infinitesimalkalkül zu entwickeln, und zweitens, keine bloße Mathematik, sondern eine mathematische Physik elliptischer Funktionen zu definieren, die auf Keplers grundlegendem experimentellen Nachweis beruhen, daß nämlich die Gravitation die einer Ellipse entsprechende ontologisch infinitesimale Wirkungsform erzeugt. Jede kompetente mathematische Physik muß sich im Rahmen dieser beiden voneinander abhängigen Aspekten von Keplers ursprünglicher Entdeckung erweisen. Die gleichen zwei Überlegungen sind in Annäherung auch die Grundlage einer kompetenten Wissenschaft der physikalischen Ökonomie.

Zum ersten Punkt: Der Vektor, der den Planeten auf der erzeugten Umlaufbahn vorantreibt, verändert sich in jedem Moment, ganz gleich, wie klein man die Zeitspanne während dieses Moments wählt. Anders gesagt, entgegen empiristischen Newtonianern wie Euler, Lagrange, Cauchy u.a. ist die Umlaufbahn ontologisch vollkommen infinitesimal. Die Aktion, die dieses Infinitesimal ausdrückt, ist in Wirklichkeit nicht imaginär, wie de Moivre, D’Alembert, Euler u.a. betonen; sie drückt die tätige Präsenz der Universalität des betreffenden Prinzips aus, hier als Beispiel die Gravitation. Aus diesem Grund betraute Kepler die zukünftigen Mathematiker mit der Aufgabe, eine Infinitesimalrechnung zu entwickeln.

Um den Kern des Arguments noch einmal zu wiederholen: Gravitation ist keine Frage der Wechselwirkung (gleichsam aus der Ferne) zwischen diskreten Körpern, sondern eine allgegenwärtige Wirkung einer universellen Existenz auf das Universum, in dem ein Körper zu jeder Zeit dynamisch lokalisiert ist. Alle universellen Prinzipien haben die gleiche Wirkeigenschaft, die sich in ihren Effekten ausdrückt.

Innerhalb der europäischen Zivilisation seit dem antiken Griechenland von Thales und Solon von Athen hat man diese Tatsache über universelle physikalische Prinzipien wohl mehr oder weniger schnell verstanden, so beispielsweise die Pythagoräer und Platon. Hinderlich für klares Denken war der reduktionistische Sophismus, für den in der Geometrie Euklids Elemente typisch sind. Die reduktionistische Annahme, Wirkung zwischen diskreten Körpern trete in einer festgelegten, linearen Ordnung einer rein formalen physikalischen Raumzeit auf, ist genau jener induzierte Wahnsinn, der bis heute das Haupthindernis für vernünftiges Denken in wissenschaftlichen Fragen ist.

Anstatt zu akzeptieren, daß Sinneswahrnehmung nur der Schatten ist, den das reale Universum auf unsere Sinnesorgane wirft, und wir dann versuchen, die experimentellen Grundlagen zu entdecken, die uns den Erzeugungsprozeß des realen Universums hinter den Schatten zeigen, interpretieren die Reduktionisten die Sinneswahrnehmung – die von der Realität auf unsere Sinne geworfenen Schatten – als Realität an sich. Diese reduktionistische Unterstellung führt zu dem gleichen kläglichen Ergebnis wie die Behauptung, Definitionen, Axiome und Postulate seien eigenständige Instanzen von Ursache und Wirkung. Riemanns mutige Rückkehr zum Standpunkt der Sphärik in seiner Habilitationsschrift von 1854 ist somit die notwendige Korrektur für den beklagenswerten Einfluß des Reduktionismus im allgemeinen und der Sichtweise von Descartes und Newton im besonderen.

Der Leibnizsche Kalkül von seiner Anfangsentwicklung spätestens 1676 in Paris bis zu seiner späteren Präzisierung als von der Kettenlinie und dem natürlichen Logarithmus abgeleitetes universelles Prinzip der physikalischen geringsten Wirkung wird Keplers Anforderung gerecht. Die reduktionistischen Fälschungen, wie sie Isaac Newton und den reduktionistischen Lehren von D’Alembert, de Moivre, Euler, Lagrange und Cauchy zugeschrieben werden, erfüllen diese Anforderung nicht.

Zum zweiten Punkt: Kepler war bewußt, daß man ein physikalisches Prinzip wie die Gravitation nicht in ein aprioristisches, euklidisches oder ähnlich sophistisches System einbringen darf. Es ist ein Grundsatz der Hypergeometrie seit Riemann, daß der Prozeß nicht in der Krümmung, sondern die Krümmung in der dynamischen Natur des Prozesses liegt. Die drei herausragenden Wissenschaftler, die Keplers Herausforderung meisterten, waren Carl F. Gauß, Niels Henrik Abel und Bernhard Riemann. Riemann übernahm von Gauß die Abhandlungen über elliptische Funktionen und die Ansätze physikalisch-hypergeometrischer Funktionen höherer Ordnung und entwickelte diese zu einer physikalischen Geometrie, die jedem kompetenten heutigen Ansatz einer Wissenschaft der physikalischen Ökonomie zugrundeliegt.

In diesem Zusammenhang sei betont, daß Keplers Methode, die ganz sicher auf dem Einfluß von Nikolaus von Kues und Leonardo da Vinci basierte, bereits implizit eine Methode der physikalischen Geometrie und nicht einer „Elfenbeinturm“-Mathematik wie der von Euklid ist. Die späteren Entdeckungen von Leibniz, Gauß, Riemann u.a. sind bereits in Keplers Arbeit angelegt. Als bedrohliches Prinzip, das ihren eigenen Sonderinteressen zuwiderlief, wurde dies bereits von den empiristischen Anhängern Paolo Sarpis von der Neuen Venezianischen Partei erkannt, die versuchten, das Wissen um Keplers Werk auszulöschen, wozu unter Anleitung des Abtes Antonio Conti Leute wie Fludd, Sarpis Lakai Galileo, Descartes und Isaac Newton eingesetzt wurden. Hier wie auch in vergleichbaren Fällen erkennt man die satanische Stimme des olympischen Zeus, wie man sie aus Aischylos’ Der gefesselte Prometheus kennt, die in den trüben, schmutzigen Ecken des heutigen Wissenschaftsbetriebs mitschwingt.

Schöpferische Gedanken, für die ich hier eintrete, Gedanken aus dem epistemologisch kompetenten modernen Wissenschaftsbereich, stammen nicht ursprünglich aus dem heutigen Europa; sie sind Teil der Wissenschaftspraxis der Sphärik, die die Pythagoräer und Platon im antiken klassischen Griechenland von ägyptischen Quellen übernahmen. Das Wissen über diese Zusammenhänge ist in der heutigen Welt unverzichtbar, um mit den verbreiteten, falschen Annahmen aufzuräumen, die aus der üblen Tradition alter Sophisten wie Euklid herstammen.

Wie der Sophismus die Wissenschaft korrumpiert

Die Erfahrungen mit meinen eigenen Entdeckungen in der Wissenschaft der physikalischen Ökonomie zusammen mit dem Wissen um die Errungenschaften und Unzulänglichkeiten der Arbeit der Fusion Energy Foundation haben mich gelehrt, daß man sich bei der Erziehung einer neuen Erwachsenengeneration fruchtbarerer kreativer Denker darauf konzentrieren muß, die Replizierung dieser alten pädagogischen Unterrichtspraktiken zu vermeiden. Lebenslange Erfahrung hat mir gezeigt, daß ein junger Mensch, der sich bei seiner Berufsausbildung den Regeln einer korrupten Darstellung der Wissenschaft unterwirft, sich geistig eher schadet als weiterentwickelt.

Wenn man bei der Erziehung intelligenter junger Menschen darauf achtet, die Fallstricke gängiger Lehrmeinungen in Wissenschaft und Kunst zu vermeiden, geben wir jungen vielversprechenden Köpfen den nötigen Freiraum, um ihr wahres Potential zu entfalten. Die Umstände, unter denen die Arbeit der LaRouche-Jugendbewegung (LYM) in den letzten Jahren vorangeschritten ist, waren ein erfreulicher Erfolg in dem spezifischen Sinn, daß er den Weg aufzeigt, wie sich die schöpferische geistige Entwicklung junger Menschen befördern läßt.

Kardinal Nikolaus von Kues erscheint somit als der größte kreative Geist, der die hervorragenden Errungenschaften der goldenen Renaissance Mitte des 15. Jahrhunderts geprägt hat. Aus Sicht heutiger Unterrichtspraktiken erscheint die De Docta Ignorantia als eine unbeholfene Schrift, wie es alle Anfänge großer intellektueller Revolutionen sein müssen. Sie erscheint auf ihre Art schwierig, denn jede Pionierarbeit in einer qualitativ neuen Richtung klassischer Formen von Wissenschaft und Kunst muß ihre eigene Sprache erzeugen, da sie den Beginn einer neuen Richtung einschlägt. Wenn spätere Arbeiten weniger schwerfällig erscheinen, dann hauptsächlich deshalb, weil die reichere Entwicklung der erforderlichen Sprache und von Ideen an sich den Katalog unserer Verständigungsmöglichkeiten erweitert hat. Wirkliche Kreativität nimmt diesen Verlauf, besonders solche kreative Bemühungen, die ein gesamtes Feld wissenschaftlichen oder vergleichbaren Denkens in Gang setzt.

Die großen Errungenschaften innerhalb der modernen europäischen Kultur, die zwar vor allem das vor den römischen, byzantinischen und mittelalterlichen Korruptionssystemen angelegte Erbe der griechischen Klassik anklingen lassen, lebten in der Renaissance wieder auf, gaben fast schon der historischen Erinnerung anheimgefallenen Ideen neue Namen und brachten neue Ideen auf, die den Vorfahren unbekannt waren. In der größten Wissenschaft und Kunst, die nach Cusas Renaissance des 15. Jahrhunderts entstanden sind, hat sich eine neue Sprache herausgebildet, nicht nur von neuen Worten, sondern von neuen Grundkonzeptionen, die den Vorläufern unserer Zivilisation unbekannt waren. In dem Maße, wie sich die LYM-Mitglieder in ihrer Selbstentfaltung klassischer Wissenschaft und Musik zuwenden, haben sie ein reiches Vokabular nichtlinearer Ideen in Wissenschaft und klassischer Kunst zu ihrer Verfügung, die in sechs Jahrhunderten des Fortschritts entstanden sind – trotz der reaktionären Rückschläge auf dem Weg dorthin. Ideen, die sich in unbeholfenen Ausdrücken versteckten, haben jetzt ein reiches Vokabular, mit dem sie sich weiterentwickeln lassen.

Der Versuch, die Wissenschaft des antiken Griechenlands zu korrumpieren, begann nicht erst mit Euklid. Die sich ergänzenden, kombinierten Einflüsse von Reduktionisten wie den „Materialisten“ Aristoteles und Euklid waren die Hauptquellen, aus der sich die intellektuelle Korruption in der europäischen Zivilisation seither speiste. Der Kern dieser Korruption läßt sich für unseren Zweck hier folgendermaßen zusammenfassen.

Wie ich oben bereits betont habe: Wir wissen, daß unsere Vorstellung von dem, was wir in der Welt außerhalb von uns wahrnehmen, nicht unbedingt eine verläßliche Darstellung der realen Welt ist. Was unser Bewußtsein wahrnimmt, ist unser Versuch, zu entdecken, wie das Universum, in dem wir leben, kontrolliert wird, und wie wir die Art, wie diese Kontrolle ausgeübt wird, ändern können.

Hinweiszeichen sollten nicht übersehen werden, aber lassen wir uns gleichzeitig nicht dazu verleiten, bloßen Zeichen, wie bloßen mathematischen Formulierungen, zu glauben.

Übersetzung: Dr. Wolfgang Lillge

Fußnote(n)

- Lyndon LaRouche, “Who Was Charles Babbage?” EIR, vom 19.5.2000.[↩]

- Doron Swade, The Cogwheel Brain (London: Little, Brown and Company, 2000). Cf. Philip and Emily Morrison, Charles Babbage and His Calculating Engines: Selected Writings by Charles Babbage and Others (Dover Publications, 1961).[↩]

- Der Begriff „experimentelle Naturwissenschaft“ bedeutet den Ausschluß von Apriori-Annahmen, wie man sie mit der Euklidischen Geometrie oder den Lehren der modernen reduktionistischen Mathematik und Physik in Verbindung bringt. Die anti-euklidische physikalische Geometrie war zwar schon in den Werken des Pythagoras und Platons enthalten und wurde von Carl F. Gauß’ Lehrer Abraham Kästner gelehrt, aber die strenge Anwendung der anti-euklidischen physikalischen Geometrie begann formell mit Bernhard Riemann Habilitationsschrift von 1854.[↩]

- Der Werdegang von Babbages Erfindung beginnt mit der Gründung der Cambridge Analytical Society 1812, die auf die Verbreitung einer köstlichen, aber geistreich-bösen Streitschrift gegen Newtons sogenannten Kalkulus zurückgeht, zu deren Abfassung sich Babbage, John Herschel und andere Mathematiker aus Cambridge unter dem Titel „The Principles of pure D-ism in opposition to the Dot-age of the University“ zusammengetan hatten. [D-ism ist eine Anspielung auf Leibniz’ Differential und Dot-age auf die Punkte in Newtons Fluxionsrechnung. „Dotage“ heißt auf englisch allerdings auch Altersschwachsinn.] Die Autoren erwähnen aber auch John Herschels berühmten Vater als den Deutschen aus Hannover, der damals der einzige kompetente Mathematiker in England war. Dieser indirekte Verweis auf den elenden Zustand von Wissenschaft und Industrie im England des 19. Jahrhunderts geht einher mit dem Umstand, daß die jungen USA, gegründet unter der Führung des Wissenschaftlers Benjamin Franklin, fast doppelt so produktiv waren als das Vereinigte Königreich unter der britischen Monarchie. Die Wirtschaftsmacht, über die die britische Monarchie verfügte, beruhte auf der internationalen strategischen Rolle, die die Ostindienkompanie seit Februar 1763 spielte, um fast der gesamten Welt außerhalb von Britannien selbst das Blut auszusaugen. Seitdem repräsentierte die britische Monarchie somit den imperialen Kern des liberalen anglo-holländischen Systems.[↩]

- Damit einige Leser nicht in eine gedankenlose Interpretation von H.G. Wells’ Absichten in seinem Ausflug ins Reich der „Science-fiction“ verfallen, sollte Thomas Huxley im Sinne von Wells’ moralischem Ansinnen in diesem Roman behaupten, daß Gutmenschen den Versuch aufgeben sollten, einfache Leute aus der Arbeiterklasse in den gleichen Rang wie die herrschende Oligarchie der englischsprechenden Gesellschaft zu erheben. „Man wird nur jene empören, die man zu erheben beabsichtigt.“[↩]

- Die Entdeckung einer heliozentrischen Umlaufbahn stammte von Aristarch von Samos. Kepler entdeckte das Prinzip der heliozentrischen Gravitation des Sonnensystems insgesamt.[↩]

- Lyndon H. LaRouche, jr., „Wernadskij und das Dirichlet-Prinzip“, FUSION, Jg. 26 Nr. 2, 2005.[↩]