Deutsche Erstveröffentlichung

Es hat sich bereits eine erkleckliche und immer noch zunehmende Menge an Zuschriften angesammelt, die sich teilweise an mich richten, aber meistens als dummes Geschwätz über mich daherkommen, und das in jenem elektronischen Fegefeuer, das, wie mir gesagt wurde, von merkwürdigen, gepeinigten, vielgestaltigen Gestalten bevölkert wird: mit Schwimmhäuten, halb Mensch, halb Maus (die Schatten von H.G. Wells’ Die Insel des Dr. Moreau!). Ein erheblicher Anteil dieses elektronischen Mülls und Geschwätzes dreht sich um die weit verbreitete Meinung, ich sei dafür verantwortlich, zwei pseudowissenschaftliche Lügengeschichten mehr oder weniger erfolgreich diskreditiert zu haben: F. Sherwood Rowlands „Ozonloch“-Schwindel und den verwandten Schwindel von der „globalen Erwärmung“.

Wie sterbende Fliegen, die in einer anderen Art Netz zappeln und deren Wehgeschrei man sich in der Phantasie vorstellen kann, gibt es in den USA zahlreiche Gesinnungsgenossen des derzeitigen britischen Labour-Premiers Tony Blair, die über Präsident Clintons offenbar standhafte Weigerung erbost sind, Forderungen der Klimaerwärmungs-Fanatiker umzusetzen, die zum Ruin der amerikanischen Wirtschaft führen würden. Auffällig bei diesen lautstarken Protesten ist die Anschuldigung, daß Leute aus meinem Umfeld aktiv daran beteiligt wären, die beiden genannten Lügengeschichten offenzulegen. Da mein Name in diesem Land und in vielen anderen Ländern auf der Welt überaus gängig ist, finden die Erbosten eine emotionale Befriedigung darin, eine „Verschwörungstheorie“ zu entwickeln, worin ich der finstere Bösewicht bin, der ihnen, Maurice Strong und Tony Blair in dieser Frage soviel Frust bereitet.

Von solchen Spinnern abgesehen, gibt es eine beträchtliche Anzahl von Leuten guten Willens, die bereit sind, ihre übernommene Meinung anhand meiner und anderer Kritik zu überprüfen. Ich führe eine Passage an, die für eine der jüngsten Zuschriften typisch ist:

„Können Sie mir Informationen zu Ihrer Wissenschaft mitteilen? Denn es gibt da draußen viele gute Wissenschaftler wie Sie, die sich mit Informationen befassen. Wenn die Topleute da draußen sagen, es könnte ein Ozonproblem geben, und wenn einige dieser Männer und Frauen nicht von den Mächtigen gekauft sind, warum sollte man sie bloßstellen? Bitte antworten Sie darauf.“

Der Schreiber dieser Zeilen irrt sich faktisch, aber die Frage ist dennoch ehrlich, wenn man weiß, wie sehr sich die „Generation X“ in den Unihörsälen und entsprechenden Einrichtungen breit gemacht hat. Die eingegangenen Zuschriften, die sich auf „Umweltthemen“ beziehen, werfen drei zusammengehörige Fragen auf. 1. Warum lehne ich die neuen Ansichten über die „Umwelt“ ab, die doch in den letzten dreißig Jahren so populär geworden sind? 2. Worauf basiert meine wissenschaftliche Methode? 3. Welche Autorität liegt in meiner wissenschaftlichen Methode der Ökonomie, die mich dazu qualifiziert, ein maßgebliches Urteil über die Kompetenz hochrangiger Scharlatane wie F. Sherwood Rowland abzugeben?

Aufgrund dieser Überlegungen erscheint es zweckmäßig, daß ich eine gemeinsame Antwort auf sämtliche eingegangenen Zuschriften abgebe, anstatt auf alle diese Anfragen, die sich auf das gleiche allgemeine Thema beziehen, einzeln zu antworten. Selbstverständlich wird diese Antwort auch auf den entsprechenden EIR-Internetseiten gepostet.

Was den Schwindel mit dem „Ozonloch“ angeht, so häufen sich die Beweise, die die Aussagen stützen, welche von den Autoren Roger A. Maduro und Ralf Schauerhammer in ihrem international bekannten Buch Ozonloch, das mißbrauchte Naturwunder1 gemacht wurden. Der Panikmache um die „Erderwärmung“ liegt die gleiche unwissenschaftliche Methode zugrunde, wie sie Rowland und andere auch bei der Erfindung des „Ozonloch“-Schwindels verwendet haben. Im wesentlichen zeigt das Buch von Maduro und Schauerhammer somit, was gegen beide Gaunereien ins Feld zu führen ist. Um auf einen Teil des Zweifels zu antworten, daß Umweltforscher „gekauft“ wurden, wie es der Leser fälschlich behauptet: Bekanntermaßen stieg Rowland zum „Topwissenschaftler“ infolge des Ansehens auf, das er erhielt, nachdem er den Schwindel mit dem „Ozonloch“ ausgeheckt hatte. Dazu zählt insbesondere seine Berufung an die Spitze der US-Wissenschaftsvereinigung AAAS, eines Klons der Britischen Vereinigung zur Förderung der Wissenschaften (BAAS).

Das Hauptargument, das gegen diese beiden und ähnliche pseudowissenschaftlichen „Ökologismen“ angeführt werden muß, läßt sich auf zwei Ebenen darstellen. Für die erste Ebene steht Dr. Dixy Lee Rays Bewertung für das Maduro-Schauerhammer-Buch:

„Jeder, der an den sogenannten globalen Umweltfragen interessiert ist, sollte dieses gehaltvolle Buch lesen und dann überlegen, ob Presseerklärungen und Computersimulationen, die nicht solide wissenschaftlich belegt sind, die Wissenschaftspolitik unseres Landes bestimmen sollten.“

Dr. Ray äußerte sich als Vertreterin jener Normen fachlicher Kompetenz, die unter Wissenschaftlern der Generationen bis zum Zweiten Weltkrieg allgemein anerkannt waren. Rowland steht für den postmodernistischen Niedergang in den intellektuellen und moralischen Normen wissenschaftlicher Tätigkeit, die sich in führenden Positionen festgesetzt und von dort die „politisch korrekte Wissenschaftsauffassung“ während der letzten 25 Jahre bestimmt hat.2

Der klinische Umstand, daß ein Inkompetenter wie Rowland soviel Berühmtheit erlangt hat, führt uns zu einem zweiten, tieferen Thema. Die postmodernistischen Wissenschaftsscharlatane in Rowlands Gefolge erhielten ihre Universitätsausbildung unter Leitung von Wissenschaftlern meiner Generation. Damit stellt sich die Frage: „Was hat die fraglichen Fakultätsangehörigen aus den Generationen des Ersten und Zweiten Weltkriegs dazu gebracht, der heutigen neuen Generation führender ,politisch korrekter’ Wissenschaftsscharlatane ihre akademischen Grade zu verleihen?“ Was ist der fragliche Fehlervirus, der Unterrichtspraktiken früherer Generationen wirklicher Wissenschaftler infiziert hat, der Virus, der von ihren „Baby-Boomer“- und „Generation-X“-Studenten in Form der Schwindelgeschichten vom „Ozonloch“ und der „Erderwärmung“ weitergetragen wird?

In meiner Schlußfolgerung werde ich zusammenfassend die antiwissenschaftlichen, politischen Motive aufzeigen, die für diese Aktivitäten Rowlands u.a. verantwortlich sind. Das sollte meines Erachtens jedoch warten, bis ich das Problem in einem wissenschaftlichen Rahmen erörtert habe. Ich beginne dabei mit einem wichtigen Beispiel des betreffenden Problems, wie ich es in meinem eigenen Fachbereich, der Ökonomie, antreffe.

Warum Karl Marx und Adam Smith inkompetent waren

Adam Smith und sein Anhänger Karl Marx begingen den gleichen fundamentalen Fehler, indem sie jeweils die Grundprinzipien der politischen Ökonomie falsch definierten. Der Unterschied zwischen beiden liegt darin, daß Marx – anders als die heutigen Manichäer wie Michael Novak und jene von der Mont-Pélerin-Gesellschaft – einräumte, daß seine Konstruktion unter einem spezifischen Trugschluß litt.3 In keiner der verschiedenen Wirtschaftslehren, die heute an den Universitäten gelehrt werden, wird eine Unterscheidung darin gemacht, ob eine Wirtschaft von Affen oder von Menschen geführt wird. In all diesen Spielarten wird insbesondere ausgeschlossen, daß sich die kognitiven Funktionen des menschlichen Geistes entwickeln können, um Entdeckungen neuer physikalischer Prinzipien hervorzubringen. Diese gleichen Prinzipien dienen der Steigerung der Wirtschaftstätigkeit und auch der physischen Arbeitsproduktivkraft pro Kopf.

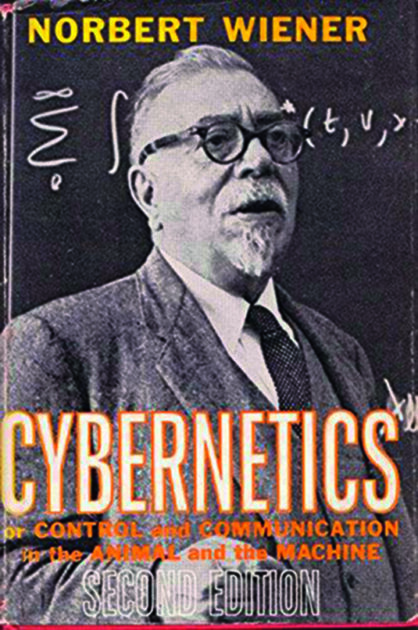

Diese Unterlassung ist riesengroß – eine ungeheure und verbreitete Inkompetenz, die praktisch alle „Mainstream“-Lehrbücher der heutigen Universitätsausbildung durchzieht. Dabei kommt der gleiche defekte Geisteszustand im Bereich der Ökonomie zum Vorschein wie bei den früheren Zöglingen Bertrand Russells, dem Erfinder der „Informationstheorie“ Norbert Wiener und dem Erfinder der „Systemanalyse“, dem Russell-Gefolgsmann John von Neumann.

Im Kern geht es um das Argument, mit dem empirisch bewiesen wird, daß sich das menschliche Individuum grundlegend von jener Klasse Menschenaffen unterscheidet, die einige Zoologen fälschlicherweise mit der menschlichen Gattung gleichstellt. Unter den Lebensbedingungen, die auf diesem Planeten seit etwa zwei Millionen Jahren herrschen, hat das ökologische Bevölkerungspotential sämtlicher Menschenaffen-Gattungen zusammen nie einige Millionen Lebewesen überschritten. Dagegen hat der Mensch, der oberflächlich die gleichen ökologischen Eigenarten aufweist wie ein Menschenaffe, bereits in der hellenistischen Periode der europäischen Zivilisation eine weltweite Bevölkerungszahl im Bereich von Hunderten Millionen erreicht, und zählt heute mehrere Milliarden.4

Archäologische und historische Erkenntnisse zwingen uns zu der Erkenntnis, daß dieser qualitative Unterschied, der den Menschen außerhalb der Ökologie, außerhalb des Bereichs niederer Lebensformen stellt, eine nur dem Menschen eigene geistige Eigenschaft ist, deren Früchte sich an der zunehmenden potentiellen relativen Bevölkerungsdichte der menschlichen Gattung mittels der Segnungen des wissenschaftlichen und technologischen Fortschritts zeigen. Zum Beispiel läßt sich ein Wurfspeer, der seit 600.000 Jahren tief im Boden des Harzvorlandes gelegen hat, nichts anderem als Menschen mit dem identischen heutigen Genotyp zuordnen.5

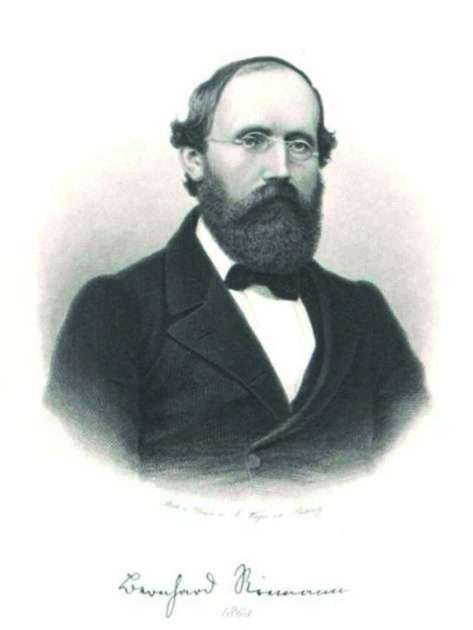

Dieser Gegenstand, die Beziehung zwischen den unverkennbaren, kognitiven Geistesfähigkeiten des menschlichen Individuums und der Zunahme der potentiellen relativen Bevölkerungsdichte der menschlichen Gattung, ist das Fundament, auf dem alle meine professionellen Leistungen seit mehr als vier Jahrzehnten beruhen. Vom Standpunkt meiner ursprünglichen Entdeckungen auf diesem Forschungsgebiet habe ich die Wissenschaft der physischen Ökonomie angewendet und fortgeführt, welche zuvor unter diesem Namen von Gottfried Wilhelm Leibniz, dem Hauptmentor meiner jugendlichen Geistesentwicklung, in seinen Arbeiten in der Zeit von 1671–1716 begründet wurde. Seit Ende 1952 profitierte meine Arbeit auch sehr von Bernhard Riemanns Revolution in der physikalischen Geometrie 1854, um die prinzipiell meßbare Beziehung zwischen von einzelnen Forschern entdeckten gültigen physikalischen Prinzipien und der Zunahme der produktiven Arbeitskraft (d. h. der Steigerung der potentiellen relativen Bevölkerungsdichte) in Gesellschaften darzustellen, die dem wissenschaftlichen und technologischen Fortschritt verpflichtet sind.

Zur Erläuterung sei gesagt, daß die Anwendung von Riemanns Prinzipien bei meinen Entdeckungen über den menschlichen Geist, das sog. „LaRouche-Riemann-Modell“6, auf den Arbeiten von Leibniz-Anhängern wie Lazare Carnot und den Kreisen um Carl Friedrich Gauß und Alexander von Humboldt beruht, um die von den Vereinigten Staaten unter Präsident Abraham Lincoln verwendeten Prinzipien umzusetzen, wodurch der auf modernen Werkzeugmaschinen basierende Wirtschaftsmotor entstand, der nach 1876 von Deutschland und anderen Ländern übernommen wurde.7

Kognition: Das aktive Prinzip in der Wirtschaft

Entscheidend für die Besonderheit meiner eigenen Entdeckungen ist, daß ich mich darauf verlegte, zu untersuchen, wie im menschlichen Geist experimentell verifizierbare Entdeckungen physikalischer Prinzipien entstehen: Ich lehne die beschränkte Sicht von „Naturwissenschaft“, wie sie üblicherweise während des 20. Jahrhunderts definiert wurde, ab, und verwende statt dessen für die Naturwissenschaft die Sichtweise der Metapher in den klassischen Kunstformen von Poesie, Drama, Tragödie, musikalischer Polyphonie und bildender Kunst in der Tradition von Skopas, Praxiteles oder der Anhänger Leonardo da Vincis wie Raffael Sanzio. Um das gleiche anders auszudrücken: Das ontologische Paradox, das zur Auflösung ein neues physikalisches Prinzip in der experimentellen Naturwissenschaft erfordert, wird von den kognitiven Prozessen des entwickelten menschlichen Geistes als genau gleiche Herausforderung betrachtet wie eine wahre Metapher im Bereich klassischer bildender oder anderer Kunstformen.

Was bei mir den Anstoß für diese Entdeckungen gab, war 1948 eine Auseinandersetzung mit Professor Norbert Wieners betrügerischer „Informationstheorie“. Meine Reaktion auf Wieners Provokation (und auf den gleichen Schwindel, den John von Neumann unter der Rubrik „Systemanalyse“ präsentierte) basierte auf meiner zuvor entstandenen tiefen Verbundenheit mit der methodologischen Sichtweise Gottfried Wilhelm Leibniz’ , eine Verbundenheit, die bei mir bereits in früher Jugendzeit einsetzte. Ich übernahm zwar diese Methode zuerst von Leibniz und nicht von Platon, von dem Leibniz selbst sie übernommen hatte, doch meine Methode ist und war streng platonisch. Die Bezeichnung „platonisch“ hat die folgende maßgebliche Bedeutung, wenn es heute um wissenschaftliche Fragen über den verbreiteten Umweltschwindel geht.

Die zentrale Frage, die sich durch den Begriff „menschliches Wissen“ stellt, ist der Umstand, daß jeder Anspruch auf solches Wissen entscheidend von der Prämisse abhängt, daß sich die Gesetze des Universums nicht im Bereich der Sinneswahrnehmung als solcher festmachen lassen, sondern vielmehr in der Fähigkeit des Menschen liegen, sein Verhalten willentlich so zu ändern, daß die Macht des Menschen pro Kopf über das Universum bewußt und meßbar zunimmt. Die geistige Aktivität, durch die diese willentliche Zunahme in der Macht über die Natur erreicht wird, ist Gegenstand des Wissens, wobei Wissen nicht mit bloßer Sinneswahrnehmung oder reinem „Lehrbuchlernen“ verwechselt werden darf.

Man kann dies auch so formulieren: Der Wissenschaft sowie klassischen Kunstformen liegt zugrunde, daß der Geist des menschlichen Individuums in der Lage ist, experimentell verifizierbare Entdeckungen physikalischer und kognitiver Prinzipien zu erzeugen, welche als Lösungen für Widersprüche dienen, die durch deduktive Methoden nicht aufgelöst werden können. Die Art von Widersprüchen, die hier gemeint ist, läßt sich anhand des folgenden allgemeinen Beispiels aufzeigen.

Man nehme an, es seien unleugbare Beweise für Phänomene aufgetreten, deren Existenz nach derzeitigem Wissensstand eigentlich unzulässig ist. Da die störenden Beweise wie auch der bisherige Wissensstand dem gleichen Vermögen zur Bestimmung der empirischen Wirklichkeit entspringen, ist der Widerspruch zwischen der bestehenden Ansicht und dem gegenteiligen Beweis in der Folge ontologisch. Deswegen läßt sich der Widerspruch zu recht als ontologisches Paradox beschreiben.

Im Parallelfall, der klassischen Kunstform, läßt sich als Beispiel Shakespeares Hamlet anführen, insbesondere der berühmte Hamlet-Monolog im 3. Akt. Hamlet weiß, daß seine gewohnten, draufgängerischen Verhaltensweisen nicht nur ihn, sondern auch das Königreich Dänemark dem Untergang weihen. Ihm ist bewußt, daß es ein gegenteiliges, anderweitiges Verhalten gibt. Ihm ist es jedoch lieber, mit seinen gewohnten Neigungen dem unausweichlichen Untergang entgegenzugehen, als die Unwägbarkeiten einer Zukunft zu wagen, „von deren Bezirk kein Wandrer wiederkehrt.“ Darum sind er und Dänemark verloren. Die Schlußszene des Dramas sieht den sterbenden Hamlet, wobei sein Freund Horatio innerhalb des Stücks zu uns Zuschauern, den überlebenden Zeugen, spricht. Horatio beschwört uns dann, den Widerspruch im Geiste noch einmal nachzuerleben, so daß wir in Zukunft dem selbst herbeigeführten Verderben entkommen, das Hamlet über sein eigenes Land wie über sich selbst gebracht hat. In allen klassischen Kunstformen nennt sich der Ausdruck solcher impliziter Dualitäten – ontologischer Paradoxe – „Metapher“.8

Die derzeitige Möglichkeit, diesen Entdeckungsprozeß eines verifizierbaren neuen physikalischen Prinzips mathematisch darzustellen, verdanken wir einer Abfolge von Entdeckungen Bernhard Riemanns im Zusammenhang mit seiner Habilitationsschrift von 1854 „Über die Hypothesen, welche der Geometrie zu Grunde liegen,“9 und den früheren Arbeiten von Gottfried Wilhelm Leibniz,10 Johann F. Herbart,11 und unmittelbar der Arbeit von Carl Gauß über die Entwicklung einer Theorie gekrümmter Flächen auf Grundlage von vorherigen und begleitenden Arbeiten über biquadratische Reste.12

Eine Zusammenfassung meiner eigenen Verfahrensweise, die zu meiner erneuten Beschäftigung mit Riemanns Habilitationsschrift von 1854 führte, dürfte dem Leser mit Blick auf das in dieser allgemeinen Antwort verwendete Material in mehrerer Beziehung hilfreich sein.

Ausgangspunkt meines Angriffs auf Wieners „Informationstheorie“ war unvermeidlich die Frage, was den Unterschied zwischen Prozessen ausmacht, deren Grundordnung entropisch ist, und beispielsweise lebender Prozesse, die in ihrer grundlegenden Ordnung antientropisch sind. Sie unterscheiden sich so auch von speziellen nichtlebenden Prozessen, besonders nichtlebenden organischen Prozessen. Den gleichen Ausgangspunkt bei allen grundlegenden Physikfragen wählten auch bekannte Anhänger von Kardinal Nikolaus von Kues, der die Prinzipien der modernen Experimentalphysik begründete, wie Luca Pacioli, Leonardo da Vinci und Johannes Kepler.

Um vom Standpunkt der Überprüfung mit entscheidenden Experimenten festzustellen, ob die Vermittlung bestimmter Ideen entropisch ist oder nicht, läßt sich daran zeigen, ob diese Vermittlung zu einer potentiellen Zunahme oder Abnahme der Entropie in der physischen Beziehung der Gesellschaft zur Natur führt. Diese Bewertung muß vom Standpunkt des eigentlich Handelnden, der Menschheit, vorgenommen werden, der diese Vermittlung empfängt. Das Versuchsergebnis muß somit nach Maßgabe der physischen Macht des Menschen über die Natur, pro Kopf und entsprechend den Verbesserungen in den demographischen Besonderheiten der entsprechenden Haushalte bewertet werden. Bei solchen Bemessungen dürfen keinerlei Geldpreise oder ähnliche fiktive Bewertungen berücksichtigt werden; wir müssen unser Augenmerk ausschließlich auf die physische Wechselwirkung des Menschen mit der Natur richten – das ist Leibniz’ und meine eigene wissenschaftliche Domäne, die Wissenschaft der physischen Ökonomie.

In bezug auf die Zu- oder Abnahme von Entropie in der gesellschaftlichen Wechselwirkung mit der Natur beginnen wir mit dem allgemeinen Umstand, daß die Steigerung der potentiellen relativen Bevölkerungsdichte der menschlichen Gattung und entsprechender demographischer Überlegungen auf Entdeckungen von Prinzipien beruht, die bei ihrer Umsetzung zu mathematisch-physikalischen Veränderungen in der Geometrie führen, d. h. wie sich die Wechselbeziehung des Menschen mit dem Universum verändert.

Veränderungen, die einer erfolgreichen axiomatischen Transformation dieser Art entsprechen, drücken sich in Aktivitäten aus, die jeweils diesen Prinzipien entsprechen. Im Erfolgsfall erfolgt der Zuwachs in der Arbeitsproduktivkraft (der potentiellen relativen Bevölkerungsdichte) „auf Kosten“ eines höheren Pro-Kopf-Werts für die „Systemenergie“, wenn letztere in bezug auf den Gesamtprozeß definiert ist. Dennoch hat im Erfolgsfall das Verhältnis der „freien Energie“ des Prozesses zu seiner erforderlichen „Systemenergie“ entweder zugenommen oder schlimmstenfalls nicht abgenommen. In der physischen Ökonomie gilt somit die folgende Definition von Antientropie: Es gilt die Bedingung, daß das Verhältnis freier Energie zur Systemenergie nicht zunimmt, trotz einer erforderlichen Steigerung im relativen Pro-Kopf-Wert der „Systemenergie“.

Diese Vorstellung eines Gegensatzes von Entropie und Antientropie liegt außerhalb dessen, was ein gewöhnlicher Universitätsabsolvent unter Mathematik versteht. Sie liegt in einem höheren, „metamathematischen Bereich“, den Leibniz als den Bereich der Analysis Situs festmachte und der ansonsten in der Mathematik in seinen begrenzteren Aspekten mit hypergeometrischen Formen modularer Funktionen verbunden ist.13 Anders gesagt, der generative (d. h. „kausale“) Unterschied zwischen Entropie und Antientropie als unterschiedliche Ordnungstypen kann in den Ergebnissen der entsprechenden Ordnung reflektiert sein, läßt sich aber nie als statistische Funktion oder mit irgendeiner anderen deduktiven Methode definieren.14

Damit kommen wir zu der unerläßlichen Rolle der klassischen Euklidischen Geometrie in der Wissenschaft. Niemand kann wohl ohne Grundkenntnisse in strikter Geometrie dieser Art Kompetenz in wissenschaftlichen Fragen erlangen, Grundkenntnisse, die man am besten etwa zu Beginn der Pubertät oder etwas früher erwirbt. Aus diesem Grund hat die Einführung der „Neuen Mathematik“ während der 1950er und 1960er Jahre die kognitiven Fähigkeiten von zwei Generationen fraglicher Universitätsabsolventen verkrüppeln lassen. Wir werden an geeigneter Stelle weiter darauf eingehen; im Moment fahren wir aber unter der Annahme fort, der Leser möge in den Genuß eines kompetenten naturwissenschaftlichen Gymnasialunterrichts von vor 1966 gekommen sein.

Um dem Leser diese Begriffsunterscheidungen zu verdeutlichen, betrachte man die sich selbst begrenzenden Eigenschaften einer deduktiven Geometrie, etwa einer Schulversion der Euklidischen Geometrie. Eine solche Geometrie läßt als Theoreme nur Sätze zu, die nicht im Widerspruch stehen zu einer fixen Reihe von Definitionen, Axiomen und Postulaten. In der Methode Platons nennt sich eine solche Reihe von Definitionen, Axiomen und Postulaten eine Hypothese. Die Einführung eines neu entdeckten und experimentell verifizierten physikalischen Prinzips oder eines neuen Erkenntnisprinzips erzeugt eine neue physikalische Geometrie, die überall im Widerspruch steht zu akzeptierten Theoremen eines bisherigen, deduktiven Beweissystems. Deswegen ist eine neue Hypothese erforderlich.15 Die Naturwissenschaft zielt somit darauf ab, immer wirksamere Hypothesen zu entwickeln. (Das Ordnungsprinzip einer solchen Abfolge entspricht Platons Idee der höheren Hypothese.) Diese höhere, metamathematische Ordnungsform, wie die Unterschiede zwischen entropischen und antientropischen Wirkordnungen, sind genau aus dem Grund „metamathematisch“, da sie die Wirksamkeit jener axiomatischen Prinzipien (d. h. der höheren Hypothese) ausdrücken, die in zuvor bestehenden, deduktiv geordneten Glaubenssystemen nicht vorkommen. Um diese Grundfragen geht es in Riemanns Habilitationsschrift von 1854, und dies sind auch die tieferliegenden Fragen der modularen, hypergeometrischen Funktionen im Werk von Gauß und Riemann.

Ich finde es pädagogisch dienlich, diese Frage am Beispiel der Berechnung des Erdumfangs durch Eratosthenes zu erläutern, jenem berühmten Vertreter von Platons Athener Akademie im 3. Jahrhundert v. Chr., einem Zeitgenossen und Korrespondenten von Archimedes. Hier eine kurze Zusammenfassung.

Spätestens seit der Zeit des Thales hatten sich im klassischen Griechenland Ansätze entwickelt, die direkt zur modernen Wissenschaft hinführten, so etwa tragfähige Prinzipien, um die Entfernung von Sonne und Mond von der Erde abzuschätzen. Aus Gründen der Größenordnung bei den verfügbaren Beobachtungsmöglichkeiten kam es notwendigerweise zu einer großen Fehlerspanne und Abweichungen unter den verschiedenen Beobachtungen. Doch trotz dieser Fehlerspanne herrschte im klassischen griechischen Denken der Eindruck vor, daß die Sonne ein sehr großes Objekt in sehr großer Entfernung von der Erde war.16 Eratosthenes, ein Vertreter von Platons Athener Akademie, der in Ägypten zu einer führenden Position aufgestiegen war, führte selbst solche Beobachtungen durch. Auf Grundlage der Kenntnisse über die Beziehung zwischen Sonne und Erde entwarf er eine konzeptionell einfache Methode der Erdvermessung.

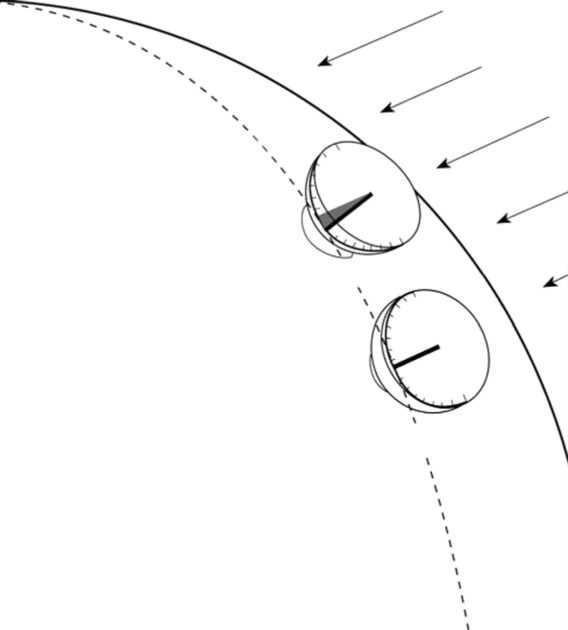

Wenn man die Meridianlinie zwischen Assuan in Ägypten (dem früheren Syene) und Alexandria astrophysikalisch definiert und dann auf einer bekannten Meßstrecke lotrechte Gnomone (Schattennadeln) in halbkugelförmige Sonnenuhren einfügt, läßt sich die Größe der Erde recht genau berechnen. (Eratosthenes’ Berechnung kam dem Erdumfang um etwa 500 km nahe.) Vergleicht man die Winkel der Schatten, die von zwei derartigen Gnomonen geworfen werden,17 wenn jeder der Schatten am gleichen Tag in Nord-Süd-Richtung zeigt, läßt sich so implizit die Krümmung der Erdoberfläche auf dem Abschnitt der Meridianlinie definieren (Abbildung 1).

Somit muß man, um alle, außer sehr kleine Bereiche der Erdoberfläche, zu messen, den Bereich der Astrophysik, den Bereich der Geodäsie, betreten. Man muß sich von den Beschränkungen einer zweidimensionalen Vermessung lösen, um eine dritte Dimension einzubeziehen, die dem Krümmungsradius18 an jedem Ort (d. h. einem sehr kleinen, infinitesimalen Intervall) der Erdoberfläche entspricht. Alle gültigen Entdeckungen neuer physikalischer Prinzipien sind diesem Experiment des Eratosthenes analog.19 Das verifizierte neue Prinzip, das den Fehler in unserer bisherigen Auffassung über das physikalische Universum korrigiert, hat den Charakter einen neuen Dimensionalität in einer physikalischen Raumzeit-Geometrie. Die Entdeckung dieser „Dimensionalität“ stellt die Lösung für das behandelte ontologische Paradox dar. Diese neue „Dimensionalität“ hat nach deduktiver Auffassung die Form eines zusätzlichen Axioms der deduktiven mathematischen Physik.

Metaphern haben somit die gleiche Form wie jene ontologischen Paradoxe, die die verifizierbare Entdeckung eines neuen physikalischen Prinzips erfordern. Der Unterschied besteht darin, daß das ontologische Paradox einen Aspekt der Interaktion des Menschen mit der physikalischen Raumzeit des Universums betrachtet, wovon er ein Teil ist; ähnlich betrachtet die Metapher die Prinzipien des menschlichen Denkens selbst. Aus diesem Grund wird Shakespeare, der meisterhafte Tragödiendichter, manchmal als „großer Psychologe“ bezeichnet. Das Problem, das gelöst werden muß, besteht darin, daß bedauernswerte Männer, Frauen und ganze Gesellschaften durch bestimmte hartnäckige geistige Blockaden daran gehindert werden, mögliche Alternativen zu ihrer selbstverschuldeten, schrecklichen Zerstörung zu entdecken und zu akzeptieren. Um diesem Schicksal zu entgehen, müssen wir jene Prinzipien des individuellen Geistes und der Beziehungen zwischen individuellen Geistern entdecken, die uns befähigen, die Wiederholung solcher Fehler zu vermeiden.

Es ist die Metapher, die die klassische Kunst definiert. Es ist die wirksame Interaktion zwischen Entdeckungen physikalischer Prinzipien, dem Bereich der Naturwissenschaft, und dem Einsatz klassischer Kunstformen, um die moralischen Prinzipien des Erkennens freizulegen, die die Wissenschaft der Menschheitsgeschichte, die Wissenschaft der physischen Ökonomie und die entsprechenden Prinzipien der Staatskunst definieren.

Schon bevor ich die Bedeutung von Riemanns Werk für die obige Fragestellung erfaßt hatte, war somit klar, daß die Häufung neuer Dimensionalitäten bei verifizierten Entdeckungen physikalischer und klassischer künstlerischer Prinzipien unmittelbar auch Ausdruck einer Zunahme der Pro-Kopf-„Systemenergie“ der Gesellschaft und gleichzeitig die Quelle einer Zunahme des Verhältnisses der gesamten „Energieleistung“ pro Kopf zur „Systemenergie“ pro Kopf war. Versteht man Georg Cantors Konzepte transfiniter Ordnung richtig im Zusammenhang mit Riemanns Entdeckungen von 1854, wird meine anti-Wienersche Auffassung von Antientropie als Grundlage einer Reform der Wirtschaftswissenschaft offensichtlich.

In der Entwicklung der europäischen Kultur führte Platon wirkliche Wissenschaft auf Pythagoras und seine Schule zurück, und die antiwissenschaftliche oder kontemplative Ausrichtung auf die Eleaten, die Materialisten, die radikalen Nominalisten und natürlich auf Platons Feinde, die Aristoteliker. Die erste, wissenschaftliche Sicht wählt als ihren Hauptgegenstand das Wechselverhältnis zwischen der Selbstentwicklung kognitiver Prozesse des Individuums und der wachsenden Existenzfähigkeit der menschlichen Gattung im Verhältnis zum gesamten Universum, mit dem die kognitiven Prozesse des Menschen wirksam interagieren. Die zweite stellt sich auf den nominalistischen Standpunkt formaler Logik und macht den Menschen zum reinen Beobachter der mit den Sinnen wahrgenommenen Wirklichkeit.

Für die Wirtschaftswissenschaft ist es somit erforderlich, daß die jungen Mitglieder der Gesellschaft eine Bildung erhalten, in der das Nacherleben verifizierter ursprünglicher Entdeckungen physikalischer Prinzipien und klassischer Kunstformen im Vordergrund steht, im Gegensatz zum bloßen Lernen anerkannter Darstellungen und Verfahren. Das ist die eigentliche Bedeutung des Unterschieds zwischen Wissen und bloßem Lernen. In der Ökonomie ist es unerläßliche Voraussetzung, daß im Wirtschaftsprozeß Beschäftigte fähig sein müssen, diesen Prozeß zu revolutionieren. Diese Fähigkeit wird durch eine Erziehung gefördert, in der der Schüler verifizierte ursprüngliche Entdeckungen nachvollzieht, anstatt nur „die richtige Antwort“ zu lernen, ohne die Erfahrung des Nacherlebens der Entdeckung gemacht zu haben. Die klassisch-humanistische Bildung – im Gegensatz zu den geisttötenden Abarten, die im heutigen Bildungswesen fast durchgängige Praxis sind – behandelt das grundlegendste Prinzip einer Wissenschaft der physischen Ökonomie. Jede Wirtschaftslehre, die dieses Prinzip ignoriert, wie die von Adam Smith oder Karl Marx, ist von vornherein eine Mogelpackung.

Das LaRouche-Riemann-Prinzip

Es war bei meiner Ablehnung von Wieners verlogener „Informationstheorie“20 gar nicht meine ursprüngliche Absicht gewesen, ein so ehrgeiziges Ergebnis zu erzielen, doch spätestens 1951 war mir klar, daß die Bedeutung des Begriffs „Wissenschaft“ ganz anders als im damaligen allgemein akzeptierten, aristotelischen akademischen Usus gefaßt werden müßte. Das wäre keine bloße Neubestimmung im Wörterbuchsinn, sondern vielmehr eine neue funktionale Bestimmung der Wissenschaftspraxis ganz allgemein. „Wissenschaft“ läßt sich nicht als die Summe experimenteller Naturbeobachtungen definieren. Um die Quelle der meisten monströsen Fehler auszuschalten, die als allgemein akzeptierte „Lehrbuchwissenschaft“ verkündet werden, war es unumgänglich, den gesamten aristotelischen Trug „wissenschaftlicher Objektivität“ zu verwerfen. Wissenschaft muß in ihrer Funktion nicht nur in bezug auf verifizierte physikalische Prinzipien, sondern vor allem auch subjektiv verstanden werden: im Sinne benennbarer Besonderheiten jener kognitiver Prozesse des Individuums, in deren souveräner Domäne alle belegten Grundsatzentdeckungen als ansonsten unmögliche Lösungen für ein verheerendes Paradox in der etablierten wissenschaftlichen Anschauung erzeugt wurden. Wir müssen verstehen, wozu entscheidende experimentelle Methoden dienen: nämlich um solche kognitiven Prozesse zu verifizieren, die experimentell verifizierbare Entdeckungen physikalischer Prinzipien hervorbringen.

Der Schlüssel zu diesem vorgeschlagenen, verbesserten Funktionsbegriff von „Wissenschaft“ und von wissenschaftlicher Methode liegt in der Wissenschaft der physischen Ökonomie, wie Leibniz sie definiert hat und wie ich sie in der damaligen Phase meiner Arbeit neuerlich definiert habe. Wenn man die Ökonomie ganzer Länder oder besser der Menschheit insgesamt als unteilbare Ganzheit betrachtet, ist die antientropische Zunahme der potentiellen relativen Bevölkerungsdichte einer Gesellschaft ein Maß für die zunehmende Macht unserer Gattung über die Natur pro Kopf.21

Diese Beziehung zwischen Gesellschaft und Universum insgesamt gründet in den erwähnten Besonderheiten der entwicklungsfähigen, souveränen kognitiven Prozesse des einzelnen Menschen, der besonderen Rolle jener kognitiven Prozesse zur Erzeugung (oder Replizierung der Erzeugung) von Grundsatzentdeckungen wie verifizierbaren Entdeckungen physikalischer Prinzipien. Dies bestimmt die potentielle Beziehung des Individuums und der jeweiligen Gesellschaft zur Natur, ein Potential, das sich in der Zunahme der potentiellen relativen Bevölkerungsdichte reflektiert. Die wirkliche Beziehung der Gesellschaft zur Natur liegt jedoch in den strukturierten sozialen Beziehungen, die in Bezug auf die Ideen für die Praxis die effektiven Beziehungen zwischen den kognitiven Prozessen der einzelnen Mitglieder der Gesellschaft insgesamt prägen.

Betrachtet man die individuellen kognitiven Prozesse und diese strukturierten sozialen Beziehungen als die subjektive Seite der menschlichen Beziehungen zur Natur insgesamt, läßt sich diese subjektive Seite mit dem entsprechenden Bereich physikalischer Prinzipien und der Änderungsrate dieses Bereichs in Übereinstimmung bringen. Die funktionalen Beziehungen zwischen Mensch und Natur müssen auf diese Weise konzeptionalisiert werden. Das ist die notwendige Grundlage für einen brauchbaren Begriff von „Wissenschaft“.

Das Zusammenspiel subjektiver und physikalischer Entwicklung definiert Umfang und Inhalt der Wissenschaft der physischen Ökonomie, so wie Leibniz sie in seinem Lebensabschnitt zwischen 1671 und 1716 begründet hat, und wie ich sie im Zusammenhang mit meiner Widerlegung des Schwindels der „Informationstheorie“ wiederhergestellt habe.

Um dieses Thema zu behandeln, müssen wir jetzt, wie oben versprochen, innehalten, um einige Leser besser ins Bild zu setzen. Dazu gehören insbesondere jene, die in ihrer Schul- und Universitätsausbildung Opfer der „Neuen Mathematik“ und ähnlicher pädagogischer Heimtücken geworden sind.

Wir haben bereits von der „LaRouche-Riemann-Methode“ gesprochen. Da Riemann 94 Jahre vor meiner Geburt geboren wurde und schon fast 70 Jahre tot war, bevor ich meine Studien über Leibniz aufnahm: Warum dann „LaRouche-Riemann“? Warum nicht „Riemann-LaRouche“? Zwei wichtige Überlegungen verlangen, daß letzterer, nicht ersterer in einer intelligiblen Darstellung des Inhalts dieser Entdeckung verwendet werden muß. Der erste, vergleichsweise einfachere Gesichtspunkt ist, daß ich erst nach einigen grundlegenden Entdeckungen feststellte, daß Riemanns Werk mir die notwendigen Hinweise lieferte, um die Meßprobleme zu lösen, die sich durch meine vorherigen Entdeckungen stellten.22 Die zweite Überlegung ist weitaus tiefgreifender, eine Überlegung, auf die ich in verschiedenen Veröffentlichungen eingegangen bin, vor allem meinem Aufsatz vom 2. Oktober 1996, „The Essential Role of ‚Time-Reversal’ in Mathematical Economics“23 („Die zentrale Rolle der ,Zeitumkehr’ in der mathematischen Ökonomie“). Der beste Weg, beide Gedanken zu verstehen, die der Verwendung des Begriffs „LaRouche-Riemann-Methode“ zugrundeliegen, beginnt mit der vorwissenschaftlichen Beschäftigung des Schülers mit der klassischen Euklidischen Geometrie.

Jeder halbwegs vernünftige Oberstufen-Unterricht in Euklidischer Geometrie dürfte zwar ausreichen, um die Grundlage für eine sinnvolle Diskussion über Grundfragen der wissenschaftlichen Methode zu legen, doch der Gegenstand läßt sich nicht weiter begreifen, ohne auf die Bedeutung von Platons dialektischer Methode hinter den Ursprüngen der Euklidischen Geometrie einzugehen, um von dort zu höheren, physikalischen Geometrien fortzuschreiten.

Die Gesamtheit der platonischen Dialoge muß nicht nur wegen der darin angesprochenen besonderen Themen studiert werden, sondern auch wegen der einheitlichen Methode, die allen einzelnen von ihnen zugrundeliegt: der sokratischen dialektischen Methode.24 Man stelle sich die Frage: Woher kommen die Definitionen, Axiome und Postulate, die der formalen Euklidischen Geometrie zugrundeliegen? Die sokratische Methode zeigt die Antwort auf. Die sokratische dialektische Methode bietet einen strengen Ansatz, um versteckte Annahmen „auszuräuchern“, die ansonsten naiverweise behandelt würden, als seien sie „selbstverständlich“ – Annahmen, die der Wahl zwischen Lehrsätzen zugrundeliegen, die man für wahr hält, und jenen, die man nicht für wahr hält. Somit ist die Euklidische Geometrie weitgehend ein Produkt der sokratischen dialektischen Methode, die sich unter dem anhaltenden Einfluß von Platons Athener Akademie bis zur hellenistischen und römischen Zeit weiterentwickelte. So gesehen, ist sie das Musterbeispiel aller formalen Denksysteme, die sich implizit auf Behauptungen stützen, die eine gemeinsame Basis in einem einheitlichen Satz von Definitionen, Axiomen und Postulaten haben.

Die Anwendung der gleichen sokratischen dialektischen Methode Platons auf diese Geometrie selbst führte zur Entdeckung neuer, höherer Geometrien. Die bedeutsamste dieser Entdeckungen geht auf die bahnbrechende Arbeit zur Begründung der modernen experimentellen Physik, die De docta ignorantia von Kardinal Nikolaus von Kues, zurück, des Hauptorganisators des Florenzer Konzils 1439-1440.25

Cusas Arbeiten über experimentelle naturwissenschaftliche Methoden führte direkt zu den Erkenntnissen einiger seiner ausdrücklichsten Anhänger wie Luca Pacioli, Leonardo da Vinci und Johannes Kepler. Sein Werk, zusammen mit den zusätzlichen Schriften von Pacioli, Leonardo und Kepler, war die gemeinsame Grundlage wissenschaftlicher Größen des 17. Jahrhunderts wie Blaise Pascal, Christiaan Huyghens und Gottfried Wilhelm Leibniz. Dieser wissenschaftliche Ansatz, bereichert und ausgewiesen in den Arbeiten vor allem von Lazare Carnot, Carl Friedrich Gauß und Bernhard Riemann, diente mir selbst als Leitlinie zu meinen Arbeiten in der Wissenschaft der physischen Ökonomie.

Die Trugschlüsse der „Neuen Mathematik“

Es war ein verhängnisvoller Fehler, zuzulassen, daß kompetenter Mathematikunterricht durch die sogenannte „Neue Mathematik“ ersetzt wurde. Das wird daran deutlich, daß die „Neue Mathematik“ den wichtigsten Fragen der Geometrie insbesondere und der Mathematik im allgemeinen ausweicht. Das sind jedoch genau die Fragen, die für den Zugang zu höheren Geometrien unentbehrlich sind.

Die moderne Wissenschaft hat gezeigt, daß die Hauptfehler in den Annahmen der klassischen Geometrie die folgenden sind:

- Die Geometrie setzte fälschlich voraus, daß ihre axiomatischen Vorstellungen von Raum und Zeit selbstevidente Prinzipien des Universums seien, unabhängig von jedem experimentellen Beweis.

- Unter Aristotelikern, Neu-Aristotelikern und anderen philosophisch reduktionistischen Kommentatoren über diese Geometrie herrscht die fälschliche axiomatische Annahme vor, die Ausdehnung in Raum und Zeit sei aus prinzipiellen Gründen stets kontinuierlich. Anders ausgedrückt, die lineare Ausdehnung könnte unendlich soweit unterteilt werden, daß es innerhalb der perfekten Ausdehnung kein Spielraum für Diskontinuitäten gibt.

Die erste umfassende Widerlegung dieser zwei Fehler hat Riemann in seiner Habilitationsschrift von 1854 geliefert, allerdings war Riemanns Entdeckung bereits in vielen Werken Platons und seiner Anhänger, wie auch Eratosthenes, angelegt. Die deutlichste Widerlegung vollkommen kontinuierlicher Ausdehnung erschien in Cusas De docta ignorantia, worin er feststellte, daß die Zahl pi nicht die Art Inkommensurabilität war, wie sie Archimedes in seiner Quadratur des Kreises angenommen hatte, sondern einer höheren Klasse angehörte, die später „transzendental“ genannt wurde.26 Mit dem diesbezüglichen Fehler hinter den Annahmen von Descartes, Newton u. a. hat sich Leibniz auseinandergesetzt, der sowohl die Frage der Katenoide („Kettenlinie“) wie auch die Huyghens-Römer-Leibniz-Bernoulli-Beweise über die isochronen Eigenschaften der Lichtbrechung27 benutzte, um zu zeigen, daß eine Mathematik, die sich einfach von Euklidischen Annahmen über Ausdehnung und Kontinuität ableitet, die Realität des physikalischen Universums nicht abbilden kann.

Ein Student, der sich gut mit Euklid und Platon auskennt, kann diese Frage ohne weiteres verstehen. Der Übergang zum Lehrstoff der „Neuen Mathematik“ hatte in dieser Beziehung verheerende, schreckliche Folgen. Werden die radikalen Forderungen von Bertrand Russells Principia Mathematica angewendet, so wie diese in die Ideologie der „Neuen Mathematik“ Einzug gehalten haben, fallen die entscheidenden ontologischen Probleme der klassischen Geometrie willkürlich weg, und es wird fälschlicherweise behauptet, daß die Ausdehnung in Raum und Zeit einfach und selbstevident linear und vollständig stetig sei. Der gesamte grundlegende Fortschritt in der modernen Wissenschaft beruht darauf, anzuerkennen, daß die Raumzeit-Ausdehnung weder selbstevident linear noch vollkommen stetig ist.

Wenn der Student die Bedeutung dieser Frage erkennt, lassen sich die entsprechenden Probleme recht gut erfassen. Ohne diese Erkenntnis ist ein Begreifen jedoch höchst schwierig, wenn nicht unmöglich.

Die gleiche Erkenntnis verschafft uns auch die Möglichkeit, zwischen einer stupiden „Elfenbeinturm“-Mathematik (bei der u.a. statistische Methoden praktisch zu einem Gott erhoben werden) und der physikalischen Wissenschaft richtig zu unterscheiden. Man muß schon verrückt sein, um anzunehmen, daß uns das äußerliche Erscheinungsbild des physikalischen Universums durch eine Art „Elfenbeinturm“-Mathematik gegeben ist und daß man die Gesetze des Universums, wie Russell in der Principia Mathematica und anderswo behauptet, aus einer von ihm definierten Mathematik ableiten könnte. Im Gegensatz zu einem Hesychasten aus der virtuellen Raumzeit der „Elfenbeinturm“-Mathematik ging ein Wissenschaftler wie Riemann davon aus, daß die Funktion der Mathematik darin bestehen sollte, sich in die Lage zu versetzen, eine geeignete, bisher nicht existente Mathematik für den Fall zu entwickeln, daß ein verifiziertes physikalisches Prinzip entdeckt wird, das die Annahmen einer zuvor eingeführten mathematischen Physik widerlegt.

Riemanns entscheidender Durchbruch hierbei war, daß er den zuvor bestehenden Irrglauben attackierte, die Ausdehnung in Raum und Zeit sei eine selbstevidente Vorstellung, anstatt, wie sich herausgestellt hat, ein Prinzip, das dem Test der experimentellen Bestätigung unterzogen werden muß. Ein Beispiel: Für Riemann genauso wie für Carl Friedrich Gauß und Wilhelm Weber reichte der von Weber geführte Nachweis von Ampères Longitudinalkraft in der Elektrodynamik bereits aus, um zu zeigen, daß es im mikrophysikalisch Kleinen keine Linearität gibt. Wie Riemann betonte, müßte man im Bereich des sehr Großen (Astrophysik) und des sehr Kleinen (Mikrophysik) Verletzungen der naiven Vorstellung linearer Ausdehnung in Raum und Zeit erwarten.

Aus dem vereinigten Werk von Leibniz, Gauß und (insbesondere) Riemann ist ein verfeinertes allgemeines Prinzip der Experimentalphysik entstanden. In der modernen agro-industriellen Wirtschaft fällt diese Entwicklung naturgemäß in den Bereich der Wirtschaftstradition der Franzosen Jean-Baptiste Colbert (der gelegentlich Leibniz unterstützte) und Lazare Carnot (einer von Leibniz’ namhafteren Anhängern in der Wissenschaft). Die Hauptaufgabe einer Erkenntnistheorie28 ist es, die Möglichkeiten zu definieren, mit denen die entsprechend entwickelten Denkprozesse des menschlichen Geistes auf ontologische Widersprüche (Metaphern) reagieren, um experimentell verifizierte neue Natur- und Erkenntnisprinzipien zu erzeugen.

Hierzu müssen wir den Prozeß des wissenschaftlichen Fortschritts als Abfolge gültiger neuer physikalischer Prinzipien darstellen. Wie bereits oben dargestellt, müssen wir wissenschaftliche Erkenntnisse als geordnete Folge immer wirkmächtigerer Hypothesen verstehen, wobei der Begriff „Hypothese“ hier im platonischen Sinne als kohärente Reihe von Definitionen, Axiomen und Postulaten in einer Euklidischen Geometrie benutzt wird. In diesem Bild muß die Reihe durch ein Wirkprinzip definiert sein, das diese Abfolge von Hypothesen erzeugt.

Dieses Prinzip ist das Wirkprinzip, das sich durch die erfolgreiche Erzeugung verifizierbarer neuer Prinzipien ausdrückt. Zu diesem Zweck ist es angebracht, den Erzeugungsprozeß der Entdeckung eines solchen neuen Prinzip als vierstufigen Prozeß zu beschreiben:

- Aufstellung eines ontologisches Paradoxes. Dies läßt sich in der Vermittlung als paradoxe Gegenüberstellung verifizierter neuer empirischer Belege mit dem empirisch bestätigten, bisher gültigen Glaubenssystem darstellen, das implizit die Existenz der neuen vorgebrachten Belege ausschließt.

- Erzeugung eines experimentell überprüfbaren neuen Prinzips, das ein neues Glaubenssystem hervorbringt, welches mit allen Beweisen übereinstimmt. Dieser Vorgang, der sich hinter dem dunklen Schirm souveräner kognitiver Prozesse des Individuums vollzieht, läßt sich in keinem Mitteilungsverfahren darstellen.

- Darlegung eines Lösungsprinzips in Bezug auf das fragliche Paradox. Dies ist mitteilbar.

- Entwurf eines Experiments, das die Wirksamkeit des entdeckten Prinzips überprüft. Dies ist mitteilbar.

Der zweite dieser vier Schritte ist der beschwerliche. Auch wenn er in deduktiven Systemen, die Mathematik eingeschlossen, nicht direkt darstellbar ist, ist er wißbar, wenn andere Köpfe, etwa Studenten, den gleichen vierstufigen Entdeckungsakt replizieren. Zudem läßt sich die Richtigkeit des individuellen Nacherlebens in Bezug auf die vierstufige Replikation verifizieren. Entgegen der empiristischen und positivistischen Lehre ist dies somit eine wißbare Vorstellung oder das, was Platon als Idee bezeichnet. Anders gesagt, jemand, der diese Entdeckung im eigenen Geist repliziert hat, kennt diese Entdeckung als Schritt zwei des hier dargestellten vierstufigen Prozesses. Er mag dann Worte oder andere darstellbare Ausdrücke benutzen, um die Existenz dieser Idee als eigenes Gedankenobjekt zu identifizieren.

Für den wissenschaftlichen Fortschritt liegt in einer solchen Idee kein Mangel, sondern vielmehr der höchste Vorzug, daß sie nicht mit grammatischer Hilfe oder deduktiven Mitteln abgeleitet werden kann. Da die Entdeckung eines verifizierbaren Prinzips, das einen ontologischen Widerspruch auflöst, wahrheitsgemäß ist, ist jeder, der Ideen ablehnt, wie Platon Ideen definiert, der Wahrhaftigkeit unfähig und deshalb als Wissenschaftler höchst vertrauensunwürdig.

Ähnlich läßt sich auch klassische Musik nicht durch eine wörtliche Auslegung der gedruckten Noten kompetent aufführen. Im Gegensatz zu stumpfsinnigen musikalischen Parodien hat die musikalische Idee in der klassischen Komposition den gleichen metaphorischen Ursprung wie die Entdeckung eines verifizierbaren neuen physikalischen Prinzips. Eine musikalische Idee liegt ebenfalls in dem entsprechenden zweiten Schritt des hier aufgezeigten Erkenntnisprozesses. Das gleiche Prinzip herrscht in allen klassischen Formen der bildenden und nichtbildenden Kunst. In dieser Qualität von Ideen liegt unsere eigentliche Menschlichkeit, unser Leben als Ebenbilder Gottes.

In der Wissenschaft ist es am offensichtlichsten, daß in diesen Ideen die größte Wirkkraft aller menschlichen Tätigkeit steckt. Sie sind höchst real, weitaus realer als jedes Objekt der Sinneswahrnehmung. Jedes wirksame physikalische Prinzip hat diese gleiche ontologische Qualität.

Bei Platon wird der Erzeugungsprozeß immer wirksamerer Hypothesen durch das, was wir hier als vierstufigen Erkenntnisprozeß dargestellt haben, als wirksames und wißbares Prinzip (Idee) der höheren Hypothese bezeichnet. Man kann auch sagen, daß die Ausbildung kreativer Denkfähigkeiten des Studenten durch Akte des Nacherlebens von Entdeckungen anstatt des bloßen Lernens aus Lehrbüchern die Denkprozesse darauf ausrichtet, ontologische Paradoxe auf bestimmte Weise anzugehen. Diese entwickelte Vorgehensweise, die sich in immer weiteren erfolgreichen Anwendungen äußert, repräsentiert somit eine wißbare Idee. Diese Qualität wißbarer Ideen entspricht dem Begriff der höheren Hypothese. Die generalisierte Vervollkommnung der höheren Hypothese führt zu der Idee, die Platons „Hypothese der höheren Hypothese“ entspricht, dem kognitiven Bereich von Platons Prinzip des „Werdens“.

In diesem Licht wird Wissenschaft zu einer Frage, die geistigen Aktivitäten von Wissenschaftlern und anderen Fachleuten aufgabenorientiert in einer Mission des ständigen wissenschaftlichen Fortschritts zu organisieren, wobei dieser Fortschritt durch eine Abfolge immer wirksamerer Hypothesen repräsentiert wird.

Dies führt uns zu dem zweiten Punkt, der Frage der „Zeitumkehr“.

Beschreiben wir einmal Sätze, die mit keiner der Definitionen, Axiome und Postulate einer formalen Hypothese, als Theoreme dieser Hypothesen, im Widerspruch stehen. Daraus ergibt sich entsprechend einer so festgesetzten Hypothese eine erweiterbare Reihe von so definierten Theoremen: Ein Theoremgitter. Solche Gitter sind mit einem Sequenzbegriff verbunden. So stellt zum Beispiel der Umstand, daß die Ableitung eines Satzes von der vorangehenden Ableitung eines anderen Satzes abhängig ist, eine Sequenz dar. Das ist die epistemologische Form, in der der Begriff „Zeit“ erscheint – allerdings nicht als selbstevidente, lineare Erweiterung, sondern als relative Erweiterung, die nicht auf rein formaler Mathematik, sondern auf der Experimentalphysik basiert.

Im Gegensatz dazu existiert eine Hypothese im Verhältnis zu ihrem Theoremgitter unabhängig von der Zeit, scheinbar „ewig“.

Bei der Einführung einer Hypothese übernimmt man somit implizit die vergangenen, gegenwärtigen und zukünftigen Sätze, Theoreme, Ereignisse usw., die in ihr stecken. Bei der höheren Hypothese liegen die Dinge analog. Somit nehmen Entscheidungen, die wir bei der Erzeugung verifizierbarer Prinzipien der Natur treffen, die Form an, daß die zukünftigen Folgen unseres Handelns unser heutiges Handeln leitet: Anscheinende Zeitumkehr.

So lassen sich die Gesetze des Universums begreifen. In dem Maße, wie unsere Wahrnehmung dieser Gesetze in einer bestimmten Anzahl zukünftiger Jahrhunderte, Jahrtausende usw. zutreffend ist, wirkt die Zukunft durch uns auf die Gegenwart ein. Das scheint „Teleologie“ zu sein, doch, wie wir gleich zeigen werden, von einer ganz anderen Art Teleologie, wie sie in den höheren Philosophiesemestern manchmal kurz gestreift wird.

Kepler und das Dreikörperproblem

An dieser Stelle sind zwei Worte der Warnung angebracht. Erstens muß man die Möglichkeit in Betracht ziehen, daß sich nicht nur der Begriff ändert, den sich der Mensch von den Gesetzen des Universums macht, sondern daß sich auch die Gesetze des Universums selbst auf etwa vergleichbare Art ändern können. Kein vernünftiger Wissenschaftler sollte so unbesonnen sein, sich für eine „Urknall“-Schöpfung oder ein Universum à la Hoyle29 auszusprechen – außer man äußert eine solche These in Form einer Frage, wie: „Fragen wir uns, warum sich einige Leute dazu verleiten lassen, ein so absurdes kosmisches Dogma wie dieses zu vertreten? Worin, meine Damen und Herren, liegt der Trugschluß, der der sich im Glauben an solche Absurditäten ausdrückt?“

Betrachten wir den Rahmen für das, was häufig als das „Dreikörperproblem“ bezeichnet wird.

Die Idee universeller Schwerkraft wurde von Johannes Kepler 1609 in seiner Neuen Astronomie eingeführt. Er brachte diesen Begriff mit dem Phänomen des Magnetismus in Zusammenhang.30 Den Ausdruck für Schwerkraft leitete Kepler aus seinen berühmten drei Gesetzen ab. Newton und seine Anhänger plagiierten später Keplers Entdeckung der Schwerkraft und machten daraus das berühmte Newtonsche „Gravitationsgesetz“ – eine rechnerische Manipulation von Keplers ursprünglicher Formulierung.31

Das Plagiat der englischen Empiristen hatte das scheinbar kuriose Ergebnis, daß die von Kepler dargestellte Ordnung des Sonnensystems funktionierte, nicht aber Newtons plagiiertes, reduktionistisches, rechnerisches Derivat. Das Scheitern von Isaac Newtons Methode ist ein Paradox, das auch als das „Dreikörperproblem“ bekannt ist. Die Lösung für dieses Paradox folgt aus dem scheinbar „teleologischen“ Argument, das wir eben dargestellt haben.

Die entscheidende Frage bei diesem Paradox ist der verbreitete Trugschluß im Gefolge von Thomas Hobbes’ Ideologie des blinden Glaubens an die Linearisierung im unendlich Kleinen.32 Um uns hierbei so kurz wie möglich zu fassen, betrachten wir die folgende Frage.

Beziehen wir uns noch einmal auf Eratosthenes’ Berechnung des Erdumfangs, indem er den Erdumfang aus der Krümmung einer abgemessenen Strecke auf der Meridianlinie zwischen Syene und Alexandria in Ägypten berechnete. Vergleichen wir dies mit der von Carl Gauß entwickelten Methode, um zu zeigen, daß der damals gerade entdeckte Himmelskörper Ceres ein Asteroid mit den harmonischen Bahncharakteristika war, die Kepler als die Umlaufbahn eines fehlenden Planeten zwischen Mars und Jupiter vermutet hatte. Vergleichen wir dies auch mit dem allgemeinen Begriff gekrümmter Flächen, den Gauß für die Astrophysik, die Geodäsie und den Elektromagnetismus entwickelt hatte. Die Frage ist: Läßt sich der gesamte Bahnverlauf einer gesetzmäßigen Bewegung aus der Krümmung eines beobachteten kleinen Abschnitts dieses Bahnverlaufs herleiten? Oder andersherum: Bestimmt sich die Bahn von Augenblick zu Augenblick durch die mechanische (d. h. „Newtonsche“) Wechselwirkung zwischen Körpern und den entsprechenden Kräften?

Keplers Überlegung, die sich von der Denkrichtung ihm bekannter Vorgänger wie Nikolaus von Kues, Luca Pacioli und Leonardo da Vinci ableitete, war, daß die Umlaufbahnen des Sonnensystems als wißbare Ordnungen im Voraus festgelegt seien. In Keplers Werk hat dieser Begriff unterschiedliche Ausdrucksformen angenommen. Doch er ging durchgehend von dem Grundsatz aus, daß diese Ordnungen, die man mit dem Prinzip der Analysis Situs in Verbindung bringen kann, ein tieferes, nicht-entropisches Wirkprinzip ausdrücken. Deswegen deckt sich seine gesamte Astrophysik mit der Ansicht, daß es grundsätzlich möglich sei, die gemessene Krümmung einer gesetzmäßigen Umlaufbahn innerhalb eines sehr kleinen Beobachtungsintervalls so abzuleiten, daß man die Gesamtheit dieses Bahnverlaufs aus der charakteristischen Kleinstwirkungskrümmung dieses kleinen Intervalls berechnen kann.

Die gleiche Methode liegt auch dem von Gauß entwickelten mathematischen Vorgehen zugrunde, mit dessen Hilfe er die Bahn des Ceres berechnete.

Anders gesagt, die Bestimmung einer sichtbaren Veränderung (Krümmung) in einem gesetzmäßig erfaßten Bahnverlauf fällt – anders als bei einem kinematisch erfaßten – in den Bereich einer höheren Hypothese. Dagegen entspricht jede Einzelhypothese nur einer mechanischen Annäherung an einen Teil der Bahn.

Wenden wir uns nun sofort der charakteristischen Krümmung in der Wechselbeziehung zwischen der menschlichen Gattung und dem Universum insgesamt zu. Wie bereits erwähnt, ist das charakteristische Merkmal, das den Menschen vom Menschenaffen unterscheidet, die antientropische Wirkung, die entsteht, wenn in dem zweiten Schritt des dargestellten vierstufigen Entdeckungsprozesses ein verifizierbares Prinzip erzeugt wird. Dies stellt eine Krümmungsänderung dar, die den Menschen vollkommen von allen anderen Gattungen unterscheidet. Dies bestimmt die spezifische physikalische Raumzeit-Krümmung des menschlichen Daseins.

Diese Krümmung findet sich unmittelbar im sehr Kleinen: In den kognitiven Prozessen des Individuums – in einer Monade.

Das gleiche Prinzip dient uns dazu, besondere Prozesse des Lebens von besonderen Prozessen des Unbelebten zu unterscheiden. Worin liegt der Unterschied zwischen einem Kohlenstoffatom, das funktionaler Bestandteil eines lebenden Prozesses ist, und einem gleichen Kohlenstoffatom, das sich anders orientiert und Bestandteil eines unbelebten Prozesses geworden ist. Man betrachte ganz grundsätzlich den Unterschied zwischen antientropischen und entropischen Prozessen als Frage der „Krümmung“ im Gauß-Riemannschen Sinn dieses Ausdrucks.

Betrachten wir ein weiteres nützliches Beispiel dieser Sache, bevor wir uns direkt der Bedeutung hiervon für die Frage der „Umwelt“ zuwenden.

Man hinterfrage das recht verbreitete, irreführende Argument, daß einer Kernfusionsreaktion gleichsinnig geladener Teilchen nahe des Atomkerns eine abstoßende „Coulombkraft“ entgegensteht. Welche Autorität hat behauptet, daß die einfache „Coulombkraft“ auf nuklearem Maßstab genauso wirkt, wie sie auf der Makroskala zu wirken scheint? Wilhelm Webers Nachweis einer elektrodynamischen Wirkung namens „Longitudinalkraft“ vor mehr als 100 Jahren hatte bereits gezeigt, daß gewöhnlich der „Coulombkraft“ zugeschriebene Annahmen nicht auf gleiche Weise funktionieren, sobald ein bestimmter geringer Abstand zum Atomkern erreicht ist.

Aus vielen entsprechenden Beispielen sollte allen ernsthaften wissenschaftlichen Denkern schon in den Jahrhunderten vor unserer Zeit klar gewesen sein, daß sich gesetzmäßige physikalische Prinzipien allgemein in einer Weise ausdrücken, die nahelegt, daß sich der momentane nach einer solchen Gesetzmäßigkeit ablaufende Vorgang so abläuft, als wenn er auf einen zukünftigen Zustand des gleichen Prozesses reagiert. Anders gesagt, vom kinematischen Standpunkt des Empiristen oder Materialisten muß es dem aufgescheuchten empiristischen oder materialistischen Ideologen so erscheinen, als wenn Kräfte auch durch Zeitumkehr wirksam sind, da man sich vorstellen kann, daß Kräfte in der Gegenwart gegensätzlich wirken, um zukünftige Zustände zu erzeugen.

Dieses Paradox wird sofort entmystifiziert, wenn man den Begriff der höheren Hypothese ins Spiel bringt. Im Verhältnis zu jedem mathematischen Ablaufschema im Zusammenhang mit einer konsistenten Hypothese ist die betreffende Hypothese mit relativ gleicher Effizienz gleichzeitig in Vergangenheit, Gegenwart und Zukunft wirksam. Im Verhältnis zu jeder geordneten Folge von Hypothesen oder den Veränderungen in den physischen Zuständen, die solchen Hypothesenfolgen entsprechen, ist die entsprechende höhere Hypothese darauf ausgerichtet, gleichzeitig und wirksam in Vergangenheit, Gegenwart und Zukunft wirksam zu sein. Man nehme dazu das Beispiel des Krebsnebels mit dem ungewöhnlichen Fall, daß die verschiedenen weit entfernten Teile dieses kohärent expandierenden Objekts in einer Art korreliert sind, daß die Grenzen der Lichtgeschwindigkeit überstiegen werden.33

Ist dies lediglich eine Behauptung des Autors? Überhaupt nicht. Es erschiene nur dann als bloße Behauptung, wenn man den Fehler beginge, sich auf den verlogenen aristotelischen Standpunkt des unbeteiligten Beobachters zu stellen. Sobald man erkennt, daß wissenschaftliche Erkenntnisse nicht durch Betrachtung des Universums gewonnen werden, sondern indem man untersucht, wie der Mensch Gedanken erzeugt, die uns befähigen, das Universum wirksam zu verändern, dann sind die Erkenntnisprinzipien, die der Entdeckung gesetzmäßiger physikalischer Prinzipien zugrundeliegen, die epistemologische Basis für die Definition der tieferen Bestimmung verifizierbarer physikalischer Gesetze.

Beispiele aus der physischen Ökonomie

Die pädagogisch einfachste und klarste Demonstration der behandelten Fragen und Prinzipien kommt aus meinem Spezialgebiet, der Wissenschaft der physischen Ökonomie. Den besten Einblick bietet eine Auswahl von fünf historischen Beispielen: Der revolutionäre Wiederaufbau Frankreichs durch König Ludwig XI. (1461–1483); das erste wissenschaftlich orientierte Modell des Wirtschaftswachstums unter Leitung des französischen Ministers Jean-Baptiste Colbert; die von der Dampfmaschine getragene industrielle Revolution, die Gottfried Wilhelm Leibniz durch seine Arbeit 1671–1716 angestoßen hat; das wissenschaftliche „Crash-Programm“ von 1792–1814, entworfen und geleitet durch den französischen Leibnizianer Lazare Carnot, dem Urheber des Werkzeugmaschinenbaus, und durch seinen früheren Lehrer und Kollegen Gaspard Monge von der Ecole Polytechnique in der Zeit von 1794–1814; und das amerikanische Modell der modernen Industriewirtschaft, die bisher erfolgreichste Form der Wirtschaftsentwicklung von 1861–1876, entworfen von dem Ökonomen Henry C. Carey unter Präsident Abraham Lincoln und in den 1870er Jahren erfolgreich übertragen auf Japan, Deutschland und Rußland.

Für unsere Zwecke fassen wir hier die Grundzüge zusammen, die sich aus der angepaßten Carey-Lincoln-Version des von Franklin und Hamilton entwickelten Modells des Leibnizschen „Amerikanischen Systems der politischen Ökonomie“ ableiten lassen, jener in den USA entwickelten aktualisierten Fassung von 1861–1876, die dann nach 1876 in Zusammenarbeit mit Henry C. Carey auf Deutschland und Rußland übertragen wurde. Nochmals, dieses letztere Modell hat die amerikanische Ökonomie im Verlauf der industriellen Revolution von 1861–1976 zur stärksten nationalstaatlichen und technologisch fortschrittlichsten Wirtschaftsmacht der Welt gemacht.34

Bei der Darstellung dieser Fragen konzentrieren wir uns auf zwei zentrale politische Umstände, die die Wirtschaft und Kultur der USA seit mehr als 30 Jahren zerstört haben, einschließlich einer damit verbundenen allgemeinen Degeneration der religiösen Kultur. Wir kommen darauf an geeigneter Stelle wieder zu sprechen.

Das Geheimnis des größten Fortschritts in den Lebensbedingungen eines Landes und seiner Bevölkerung findet sich in dem Programm der Ecole Polytechnique unter Leitung von Gaspard Monge. Kernpunkt dieses Programms war die Ausbildung sogenannter „Brigaden“ junger Studenten, die auf diese Weise das fortschrittlichste und mächtigste Zentrum wissenschaftlicher und technischer Arbeit in der damaligen Welt aufbauten. Zum Verständnis dieses Erfolges sei auf das oben dargestellte vierstufige Modell verwiesen. Verwiesen sei auch auf Lazare Carnots Anwendung des Werkzeugmaschinen-Prinzips zur hochpräzisen Massenproduktion, das Carnot, der „Organisator des Sieges“, 1792–1794 einführte und damit alle Armeen, die damals nach Frankreich eindrangen, vernichtend geschlagen hat; gleichzeitig entwickelte sich innerhalb dieser zwei Jahre die französische Armee zur stärksten und technologisch modernsten in der damaligen Welt.

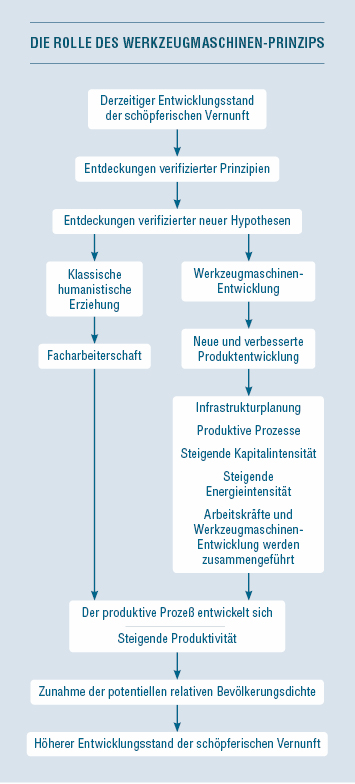

Man bringe das vierstufige Modell klassischer Schul- und Hochschulerziehung und das Werkzeugmaschinen-Prinzip in Zusammenhang mit der Wirtschaftsrevolution von Carey und Lincoln 1861–1876 und deren Nachbildung durch Deutschland und der Fraktion um Mendelejew und Witte bei der industriellen Entwicklung Rußlands 1876–1905. Man vergleiche dies mit Franklin Roosevelts Wirtschaftsrevolution während des Zweiten Weltkriegs und mit dem deutsch-amerikanischen Raumfahrtprogramm in der Zeit von 1945 bis 1966.35 In dem begleitenden Flußdiagramm (siehe nebenstehendes Schaubild) sind die Prinzipien einer auf der Werkzeugmaschinen-Entwicklung basierenden Wirtschaft dargestellt.

Die Weiterentwicklung des (kreativen) Denkvermögens des einzelnen Studenten durch wiederholte Erfahrungen mit der vierstufigen Methode befähigt diesen dazu, seine so vor allem auf der zweiten Stufe entwickelten schöpferischen Fähigkeiten darauf zu konzentrieren, Probleme zu lösen, die sich in Form eines ontologischen Paradoxes in der Wissenschaft oder als Metapher in klassischen Kunstformen stellen.36 Wie Abbildung 2 zeigt, führt die Entdeckung verifizierter Prinzipien als Produkt und meistens als Nebenprodukt einer solchen klassisch-humanistischen Schul- und Hochschulerziehung zu einem Florieren neuer Prinzipien der Werkzeugmaschinen-Entwicklung und auch zu hoch anpassungsfähigen Arbeitskräften, die in der Lage sind, neu eingeführte Technologien zu meistern.

Dieses Beispiel verdeutlicht den Umstand, daß ein nachhaltiger Nettogewinn einer Volkswirtschaft nur durch die antientropische Wirkung dieser oder verwandter Arten der Verbreitung und Investitionen in den nützlichen wissenschaftlichen und technologischen Fortschritt entsteht. Die wirkende Kraft, die diese Antientropie erzeugt, ist die Kraft, die sich als zweiter Schritt in dem vierstufigen Prozeß äußert.

Diese Kraft, dieses souveräne kognitive Potential des Menschen, ist der Ort, der definiert, daß jeder Mann und jede Frau nach dem Abbild Gottes geschaffen ist. Die Leidenschaft, die mit jener im zweiten Schritt ausgedrückten schöpferischen Aktivität verbunden ist, nennt sich im klassischen Griechisch Platons und des Apostels Paulus agápe. Im 1. Korintherbrief 13 des Paulus wird dieses Prinzip in den Mittelpunkt des gesamten Christentums gerückt. Die christliche Nächstenliebe ist agápe – sowohl als Hingabe charakteristisch menschlichen Handelns (d. h. des schöpferischen Denkens) wie auch als Förderung jener Qualität, die sich in jedem Menschen ausdrückt, der „nach dem Abbild Gottes geschaffen“ ist.

Im Gegensatz dazu ist es angemessen, die Gesellschaftstheorien von Thomas Hobbes, John Locke, Bernard Mandeville und Adam Smith als satanisch zu beschreiben. Das Konzept des „Freihandels“ oder des laissez-faire, wie sich François Quesnay ausdrückte, läßt sich am besten verstehen, wenn man in ihm ein Relikt des Manichäismus sieht, insbesondere der Bogomilen-Ausrichtung des Manichäismus. Dieser leugnet, daß es das, was den Menschen zum „Abbild Gottes“ macht – das schöpferische Denken –, wirklich gibt, und ersetzt das agápe in der Ordnung des zwischenmenschlichen Verhaltens der Gesellschaft mit wollüstigen bestialischen Alternativen wie den sieben Todsünden. Der „Freihandel“ ist somit nichts anderes als die Lehre, wie sie Mandeville und sein Getreuer von Hayek beschreiben; sie meinen, das Gute entstehe nur dann, wenn man dem Bösen eine uneingeschränkte Lizenz erteilt. Für sie gibt es im Menschen nur die lineare Erweiterung jener Leidenschaften, die mit den sieben Todsünden verbunden sind. Im Kern läßt sich Friedrich von Hayeks satanische Definition von „Freiheit“ am besten mit dem Motto beschreiben: „Laß den inneren Schweinehund los!“

So wie institutionalisierte Abläufe die vom einzelnen in der Gesellschaft ausgedrückte „Krümmung“ prägen, bestimmen wir das charakteristische Merkmal der Bahnkurve, der die Geschichte dieser Gesellschaft folgen wird.

Betrachten wir das allgemeine Prinzip erneut im Lichte dieses Beispiels aus dem Bereich der politischen Ökonomie.

Um die Natur der gesetzmäßigen Wechselbeziehungen zwischen offenbar unbelebten, lebenden und kognitiven Prozessen zu bestimmen, muß man sich zunächst klar machen, daß diese Prozesse durch unterschiedliche eigene physikalische Raumzeit-Krümmungen voneinander abweichen, besonders in ihren infinitesimal kleinen Wirkintervallen. Wenn man dann meint, eine Wechselbeziehung zwischen Prozessen derart charakteristischer, voneinander verschiedener Krümmungen mit Hilfe von „Modellen“ definieren zu wollen, die willkürlich mechanistische, lineare Wechselbeziehungen im sehr Kleinen voraussetzen, kann man sicher sein, daß die daraus folgenden Berechnungen absurd sind und nichts mit der Realität zu tun haben.

Besonders wenn man „ökologische“ Berechnungen anstellt, die die Rolle menschlichen Denkens in der technologischen Entwicklung der Wirtschaft unberücksichtigt lassen, hat die daraus folgende Beurteilung der Beziehungen zwischen Mensch und Natur nichts mit der Realität zu tun. Die Ausbreitung von Krankheiten infolge des Verbots von DDT, die steigende Morbidität weltweit aufgrund der Folgen des „Ozonloch-Schwindels“ auf die Kühlkette von Nahrungsmitteln und die drohende Zunahme der Sterberate auf der ganzen Welt infolge des Schwindels der „globalen Erwärmung“ sind Warnungen vor den Gefahren, die sich aus dem linearisierten Denken über lebende Prozesse ergeben.

Es ist deshalb mehr als gerechtfertigt, die Frage über den Trugschluß der Linearisierung so zusammenzufassen: Wenn man die Wirkung der Ökonomie auf die Ökologie anhand der heute allgemein akzeptierten Wirtschaftstheorien beurteilt, sind die daraus resultierenden Schlüsse notwendigerweise falsch.

In Sachen Beweis

Bei allem, was achtlos „Umweltforschung“ genannt wird, gibt es zwei breite Einteilungen.

Eine ist der Standard wissenschaftlichen Beweises, der von Spezialisten in den entsprechenden Bereichen vor 1962–1972 allgemein akzeptiert wurde. Beweise aus diesen Kreisen mögen ihre problematischen Seiten gehabt haben, aber der Praxisstandard in dieser Zeit lief „im Großen und Ganzen“ auf Wahrhaftigkeit und Kompetenz hinaus. Dieser Standard funktionierte, nicht weil die dabei verwendete Mathematik besonders gut war; er funktionierte gewöhnlich trotz schlechter mathematischer Modelle, denn der zum Zwecke der Politikgestaltung verwendete Standard beruhte auf einer entscheidenden experimentellen Demonstration des Prinzips und nicht auf mathematischen Modellen als solchen.

Der zweite Standard ist ein ideologischer, der mit dem einflußreichen „1001-Club“ in Verbindung steht. Dieser wurde von dem britischen Prinzgemahl Philip und der niederländischen Drohne Prinz Bernhard als Zusatz zu dem 1961 gegründeten World Wildlife Fund eingerichtet. Die Vorgaben dieses zweiten Standards sind gewöhnlich nicht nur inkompetent, sondern ein offener Schwindel. Drei prominente Beispiele für solche Betrügereien sind die oben genannten: Rachel Carsons verlogene Anschuldigungen gegen DDT – für die kein einziger wissenschaftlicher Beweis erbracht wurde –, F. Sherwood Rowlands „Ozonloch“-Schwindel und der Schwindel der „globalen Erwärmung“.

Eine der aufschlußreichsten Fallstudien findet sich in den Kampagnen gegen die Nutzung der Kernspaltung als Energiequelle. Als Antwort auf die Frage der Kritiker: Wie soll die benötigte Energieversorgung gesichert werden, wenn wir aus der Kernenergie aussteigen? antworten die Anti-Atom-Propagandisten entweder mit Lügen oder einfach nur mit dem dummen Geplapper umnachteter Analphabeten.

Die wichtigsten Parameter, die als Faustregel für die Definition der wichtigsten Energiequellen der Gesellschaft dienen, sind Leistung pro Kilogramm Brennstoff und die „Energieflußdichte“ bei der nutzbaren Energieerzeugung. Im letzteren Fall heißt dies die Menge nutzbaren Energieflusses durch eine Querschnittsfläche pro Sekunde. Kilowatt pro Quadratzentimeter ist eine solche Faustregel-Messung. Dieser Begriff ist so alt wie Sadi Carnots Ecole Polytechnique und genauso dauerhaft. Je höher und je kohärenter die Organisation der Energieflußdichte ist, desto effizienter ist der übertragene Energiefluß pro Wattstunde.

Das Problem ist nicht nur die bloße Wärmeeffizienz, sondern das Verhältnis der Energieflußdichte im sehr Kleinen zum Schwellenwert für bestimmte physikalische Reaktionen. Somit ist das Technologieniveau und damit die durchschnittliche erreichbare Arbeitsproduktivität durch die Energieflußdichte und durch damit zusammenhängende Kohärenzbetrachtungen usw. beschränkt.

In der Physik im allgemeinen sind heute zum Beispiel die absehbaren Energiequellen der Zukunft erstens immer weiter verbesserte Generationen der kontrollierten thermonuklearen Fusion und, zweitens, die verläßlich noch höheren Ordnungen der Energiedichte, wenn es möglich sein wird, Materie/Antimaterie-Reaktionen als Energiequelle z.B. bei Erkundungen innerhalb des Sonnensystems und dem stellaren Raum zu kontrollieren.

In diesen Fragen sind die politischen Befürworter „weicher“ Energieformen ahnungslose Fanatiker. Politisch gesehen sind sie gefährliche Ahnungslose. Sie stehen für eine Gesellschaft, in der die „Sensitivität“ einer „Selbsterfahrungsgruppe“ mit Wahrhaftigkeit und sogar Vernunft verwechselt wird. Man kann auch einfach sagen, daß sie im Grunde unmoralisch sind. Wenn man sie als „aufrichtig“ beurteilen sollte, dann muß man sagen, daß sie so „aufrichtig unmoralisch“ sind, wie es vielleicht die Anhänger von Satan sein würden.

Unter den Haupturhebern der modernen technologiefeindlichen Kulte ist der britische Prinzgemahl Philip, Mitbegründer des World Wildlife Fund 1961 und des „1001 Club“, durch und durch böse, ebenso wie Prinz Bernhard der Niederlande, der andere Mitgründer, der sich am Tag seiner Hochzeit mit einer niederländischen Prinzessin die Zeit nahm, sein SS-Austrittsschreiben an Hitler persönlich mit „Heil Hitler“zu unterzeichnen. In den letzten Jahrzehnten ist es diesen Möchtegern-Mephistos gelungen, eine Vielzahl von Möchtegern-Fausts zu rekrutieren. Mit anderen Worten:

Durch den Einfluß von Stiftungen und anderen ideologisch motivierten Institutionen, die in das gleiche Paradigma wie der „1001 Club“ passen, wurde ganz allgemein eine Art Industrie von Umweltlügen etabliert. Hochschulabsolventen und andere haben festgestellt, daß es am einfachsten ist, ihren Lebensunterhalt zu bestreiten, wenn man sich auf die Gehaltsliste einer Institution setzen läßt, die angeblich die eine oder mehrere solcher Umweltlügen wissenschaftlich unterstützen wollen.

Rowland fällt dabei besonders auf, nicht nur weil sein persönlicher Ruhm auf solchen korrupten Praktiken beruht, sondern auch, weil er dafür steht, daß die Computertechnologie als Ersatz für Wissenschaft mißbraucht wurde, indem betrügerische Studien von Profis verfertigt werden, die sich für ihre Karriere auf diese Weise praktisch wie Callgirls oder Streetwalker prostituiert haben. Die Tatsache, daß sich diese korrupte Praxis so lange verbreiten konnte, hat den einst jugendlichen „Ökokriminellen“ der gestrigen Pseudowissenschaften jenes schütter werdende Haar und jene weißliche Haarpracht verpaßt, was vom leichtgläubigen Betrachter allzu oft als Zeichen reifer Urteilsfähigkeit mißgedeutet wird. Der „Ozonloch“-Schwindel hat durch Rowlands persönlichen Erfolg und wegen der immer preiswerter werdenden PCs das betrügerische „Computermodell“ zum Modeführer der „Umweltindustrie“ gemacht.

Wenn jemand auf die hier beschriebene Weise unmoralisch geworden ist, ist es nicht erforderlich, ihm auch noch seine Korruptheit nachzuweisen. Um den Teufel böse zu nennen, ist es nicht notwendig zu beweisen, daß er bestechlich ist. Um auf den zweifellos alltäglichen Gedanken eines Fragestellers einzugehen: Um zu beweisen, daß Satan böse ist, ist es nicht notwendig herauszufinden, daß er oder ein Sklavenhalter beispielsweise gekauft wurde.

Schließen wir mit einer passenden Beobachtung zu diesem Thema, dem Thema Bosheit. Wenn ein schreckliches Verbrechen begangen wurde, wird von vielen zu häufig darüber spekuliert, was ihrer Meinung das Hobbessche oder Lockesche „Eigeninteresse“ gewesen sein könnte, das den Täter zu solch gräßlichem Verhalten motiviert haben könnte. An diejenigen, die sich dazu hergeben, solche Spielchen mitzuspielen, sei ein Wort der Vorsicht gerichtet. Es ist eine Tatsache, daß manchmal ein Mörder tötet, weil er es genießt zu töten, und er tötet auf eine außerordentlich perfide Weise, weil sein Impuls nicht anders befriedigt werden kann. Manchmal geht es weniger darum, daß das Opfer Haß hervorgerufen hat, sondern daß dieser Haß ein geeignetes Opfer gesucht hat, um sich auszudrücken. Niemand tötet aus „unpersönlichen Motiven“, und in Zeiten, wo das größte Böse geschieht, ist es zunehmend so, daß Heimtücke immer seltener aus wahrgenommenem „Eigeninteresse“ entsteht, sondern daß der Ausdruck von Heimtücke selbst zum „Eigeninteresse“ des Täters wird.

Viele Umweltschützer sind ehrliche Analphabeten, von denen man sagen könnte: „Sie wissen es nicht besser.“ Viele, wie die meisten der „Radikalen“ der Campus-Unruhen von 1964–1968, wurden durch eine Art Gehirnwäsche zu dem gebracht, was sie taten, denn es kam zu einem Ausbruch von Labilität, Suggestivität und Realitätsflucht infolge der Kubakrise von 1962, der Ermordung von Präsident John F. Kennedy, der abendlichen Schreckensnachrichten aus Vietnam und dem Mord an Martin Luther King. Allerdings waren Leute wie die Prinzen Philip und Bernhard oder die Dame Margaret Mead, die ihre unglücklichen Opfer ausnutzten, um in ihnen diese anomalen Zustände zu induzieren, wahrhaft teuflisch, und ihre Motivation war die Heimtücke an sich.

Wenn jedoch die Ablehnung von Wahrhaftigkeit zu einem funktionalen Geisteszustand wird, hat die moralische Korruption bereits das Kommando über diesen Menschen übernommen. Dieser böse Geist muß dann nicht mehr besonders überlegen, um sich aufgefordert zu fühlen, die Eigenart auszudrücken, die sich ihm bemächtigt hat.

Übersetzung: Dr. Wolfgang Lillge

1. Roger A. Maduro und Ralf Schauerhammer, Ozonloch, das mißbrauchte Naturwunder, Dr. Böttiger Verlags-GmbH, 1992.

2. Die „politisch korrekten“ Sprachcodes, die an einigen führenden Universitäten von heute eingeführt wurden, sind bezeichnend für gegenwärtige Definitionen „politischer Korrektheit“ samt „Mainstream-Meinungen“ und erinnern an George Orwells Fiktivromane „Die Farm der Tiere“ und „1984“. Der nichtfiktive, reale Vorläufer für die heutige „Mainstream-Meinung“ war Josef Goebbels Nazi-Propagandaministerium.

3. Ich habe in jedem Ökonomiekurs, den ich auf dem Campus verschiedener Universitäten zwischen 1966 und 1973 hielt, gegenüber meinen Studenten erklärt, Marx habe festgestellt, daß in seinem „Modell“ die Betrachtung der „technischen Zusammensetzung des Kapitals“ nicht berücksichtigt worden sei; dieser „Ausschluß“ ist der formale Grund für den Fehler in seinen Modellen der „erweiterten Reproduktion“ und der „fallenden Profitrate“. Dieses Eingeständnis ist Ausdruck dafür, daß er aus seinen Untersuchungen auch das entsprechende kognitive Prinzip ausgeschlossen hat. Die Verwendung des Begriffs „manichäisch“ mit Blick auf Hobbes, Adam Smith, die Mont-Pélerin-Gesellschaft usw. ist weder ein Gleichnis noch eine Übertreibung. Seit Thomas Hobbes’ Leviathan leitet sich die gesamte Wirtschaftslehre der englischen und britischen Empiristen und der französisch-österreichischen Positivisten von dem stetigen Einfluß des notorischen, neo-manichäischen Bogomil-Kults in der Region um Toulouse und der Rhône ab. Bernard de Mandevilles Bienenfabel, das offizielle „Alte Testament“ von Friedrich von Hayeks Mont-Pélerin-Gesellschaft, übernimmt explizit Hobbes’ „Krieg jeder gegen jeden“ in das Gebot, daß Gutes spontan entstehe, wenn man bösartigem Verhalten die Lizenz des laissez-faire verleiht. Wie bei allen Abarten des Manichäismus beruht der Beweggrund von Hobbes, John Locke, Bernard Mandeville, Adam Smith, Jeremy Bentham, John von Neumann u.a. darauf, daß Satan das Universum des Fleisches (den materiellen Bereich) regiert, während sich Gott (vorbehaltlich eines Jüngsten Tages) auf den kleineren, unsagbaren Bereich des Geisteslebens im Menschen, der Familie und der Kirche beschränken muß. Entsprechend argumentieren die Manichäer wie der Oberste US-Richter Antonin Scalia, daß Satans Kirche, „dem Marktplatz“ in Michael Novaks Wirtschaftstheologie, kein moralischer Zweck übergestülpt werden dürfe.

4. Lyndon H. LaRouche, jr., „The Coming Pearl Harbor Effect“, Executive Intelligence Review, 12. September 1997.

5. Ebenda. Siehe auch Hartmut Thieme, Lower Palaeolithic hunting spears from Germany. In: Nature. Band 385, 1997, S. 807-10.